聊起自动驾驶,总让人觉得那是未来的事。可实际上,这东西正一天天扎进我们的生活里。想让车自己开得稳当,背后得有三根结实的柱子撑着:数据、工具和算法。数据就像是模型的粮食,得吃得杂,吃得精。不光要有阳光大道上的信息,那些暴雨天、大雪夜,还有各种不按常理出牌的行人、自行车,都得喂给模型见识见识。工具呢,就是一套趁手的家伙事儿,从怎么收集数据,到怎么清洗、打标签,再到训练模型、装到车上,每一步都有讲究。比如自动打标签的工具,能省下大量人力;分布式的训练框架,能让模型学得更快。算法库就更关键了,它把感知、决策、控制这些模块的先进模型都攒在一起,让开发者能像搭积木一样调用、优化。这三样凑齐了,才算是给自动驾驶大模型搭好了台子。有些走在前面的大厂,已经玩得很溜了,靠车在路上跑悄悄收集海量真实数据,再配上自己打造的超级计算机和神经网络的架构,形成了一个从数据到决策、不断自我升级的循环。

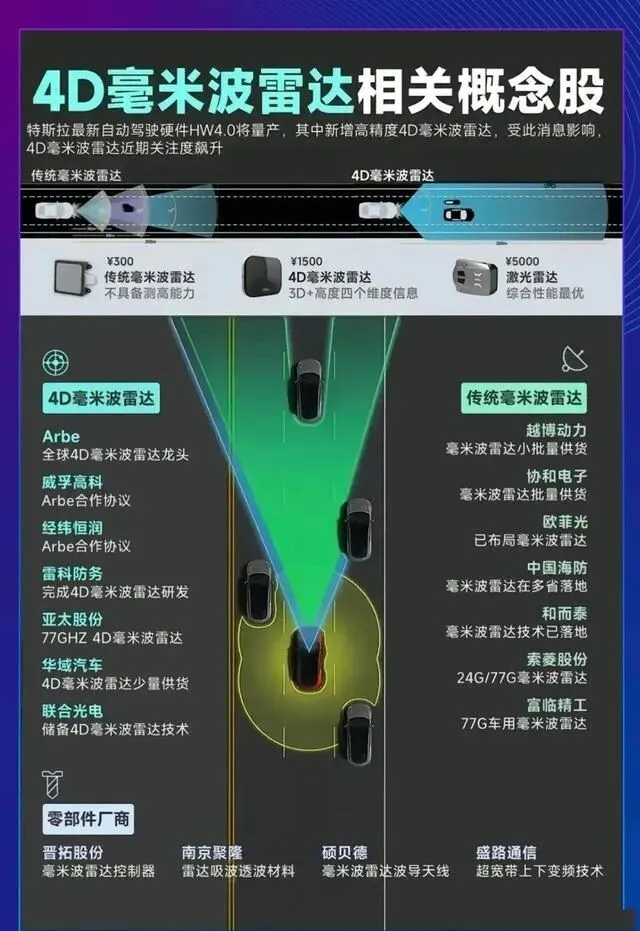

说到感知,3D目标检测是个躲不开的硬核任务。车能不能“看”得准,全看它了。以前光靠一个传感器,总有点捉襟见肘。摄像头怕光线太强或太暗,激光雷达打出来的点有时候稀稀拉拉的,毫米波雷达呢,看东西轮廓又有点模糊。于是大家想了个法子,让它们联手。把激光雷达精确的几何位置信息,和摄像头清晰的图像语义信息捏在一起,不仅能知道前面有个东西,还能分清那是个人还是辆车。再加上毫米波雷达提供的速度数据,对运动目标的把握就更稳了。当然,让几个传感器协同工作也不容易,它们的安装角度得校准得严丝合缝,数据在时间上也得对齐,差一点可能就差很远。技术上有两种主要的路子,一种叫后融合,让各个传感器先自己做出判断,然后再投票决定最终结果,速度快,适合需要立刻反应的场合。另一种叫前融合,一开始就把不同传感器的原始数据映射到同一个空间里,保留的信息更丰富,但对算力的要求也更高。各家车厂会根据自己车上装了什么传感器,以及车载芯片的算力,来选合适的方案。

只看眼前这一帧画面,有时候会看走眼。比如一辆车被前车挡住了半边,或者一个人突然从路边窜出来。这时候,如果把时间这个维度加进去,看看连续几帧画面里目标是怎么动的,心里就有谱多了。模型可以推测被部分遮挡的物体完整的样子,也能预判一个正在加速变道的行人接下来的位置。以前处理这种时序信息,常用3D卷积或者循环神经网络,但计算负担挺重。最近一些研究开始转向一种基于注意力机制的架构,它能更好地捕捉长距离的依赖关系,既能用好时间线索,又把计算量降下来一些。

想法再好,模型再厉害,最终都得在车上的那个小盒子里跑起来。这就对模型的身材和饭量提出了苛刻要求:推理速度要快,耗电要省。那些又大又笨重的模型直接塞进去是不行的。所以得给模型“瘦身”。知识蒸馏是个办法,让一个训练好的大模型像老师一样,去指导一个小模型,把小模型教得又聪明又轻巧。网络剪枝则是把模型里那些不怎么起作用的连接或者层去掉,减掉赘肉。量化技术就更直接了,把高精度的浮点数运算转换成低精度的定点数运算,降低对硬件计算单元的要求。还有一些专门为3D数据设计的轻巧架构也挺有意思,比如把点云数据转换成一种类似2D图像的格式,然后用更高效的2D卷积来处理,速度提升很明显。在实际用的时候,得会做权衡。在高速上跑,可能稍微牺牲一点精度,换来更快的反应时间更紧要;到了城里车水马龙的地方,那肯定还是先把检测的准确性放在第一位。

路面上啥稀奇事儿都可能发生。这就是所谓的长尾问题。要增强模型的泛化本事,关键得让它“见多识广”。训练的数据集必须包罗万象,不同地域的道路、各种恶劣天气、白天黑夜、甚至不同国家的交通标志,都得让它学。比方说,北方冬天被压实的积雪路面,南方雨季反光湿滑的标线,乡村小道那些不那么规范的路牌,都是宝贵的教材。光靠真实采集还不够,还能用合成数据技术来模拟那些极端情况,比如生成一个突然冲出路面的小孩,或者一辆强行加塞的车,进一步扩充数据储备。采集这些数据时,标注的质量也得死死盯住,确保模型学到的关联是正确的。这样“喂”出来的模型,才不那么娇气,更能适应真实世界的复杂性。

还有个头疼的问题,叫“领域差异”。简单说,就是训练模型用的数据和它真正要干活的环境,不是一回事。比如模型在晴天数据上练得挺好,一到雨天就抓瞎。这时候就需要一些技术来弥合这个差距。对抗训练是种思路,它让模型在学习时,努力提取那些不受天气、光照影响的本质特征。特征对齐则是想办法让模型从晴天和雨天数据里学到的特征,在统计分布上尽量靠近。还可以用自训练的方法,利用目标环境里大量没有标签的数据,让模型自己先做出预测,生成一些伪标签,再用这些数据反过来迭代优化自己。实际应用中,这些方法经常组合起来用,先打个基础,再精细调整,让模型能更好地适应千变万化的真实路况。

车子卖出去上了路,世界还在变。新的交通标识会出现,道路施工的样式也在更新。总不能每有点新变化,就把所有车召回,把模型重新训练一遍吧?这就引出了持续学习的概念。它希望模型在部署之后,还能像人一样持续学习新知识。比如遇到一种新的临时路障,模型能通过少量新数据就快速认识它,并把新知识整合到原有模型里,同时还不忘掉以前学过的旧知识。这其中的挑战在于如何避免“学了新的,忘了旧的”。有一些技术手段,比如弹性权重巩固,它会标记出对旧任务很重要的模型参数,在新学习时对这些参数的保护性更新;或者记忆回放,在学习新东西的同时,时不时用一些旧数据复习一下。这让自动驾驶系统能真正跟上时代的变化。

在把模型装到真车上路之前,大量的测试和验证是在虚拟世界里完成的。这就对仿真技术提出了极高要求。模拟一个城市路口,红绿灯、斑马线、行人、车流,一个都不能少;模拟高速公路,就得有清晰的车道线、合理的车距和变道行为。车辆动力学模型要能准确反映车的质量、惯性、轮胎与地面的摩擦,让加速、刹车、转弯这些动作符合物理规律。传感器模型则要模仿摄像头、激光雷达、毫米波雷达的“感官”特性,包括它们固有的噪声、图像畸变、以及被遮挡时的效果。比如激光雷达打在远处和近处物体上的点云密度是不一样的,不同材质的物体对激光的反射也不同,这些细节在好的仿真里都要考虑到。物理引擎的精度直接决定了仿真环境的可信度,一个高精度的引擎能模拟出急刹车时轮胎的轻微打滑,或者潮湿路面上的倒影,为模型提供一个近乎真实的试验场。

最有价值的测试,是闭环测试。它不像开环测试那样只跑一遍单向流程,而是让模型的决策输出,直接控制仿真环境里的虚拟车辆运动,车辆运动产生新的传感器数据,再反馈给模型,形成一个完整的循环。这就能模拟出真实驾驶中那种连续的、相互影响的决策过程。比如你的车因为前车减速而刹车,这个动作又会影响到后面跟着的虚拟车辆,它们也得做出反应。通过这种闭环测试,可以从整体上评估整个系统的表现:安不安全,看看有没有发生碰撞、是否保持了安全距离;舒不舒服,看看加速减速是不是平顺、有没有急刹;效率高不高,看看通行时间、能耗怎么样。只有经过这样严苛的虚拟考验,才能尽可能把问题暴露和解决在上路之前,让未来的自动驾驶更可靠、更安心。