随着deepseek的火热,曾经长期处于相对边缘位置的强化学习成为从冷门到主流的AI技术。在自动驾驶领域,端到端架构逐渐成为行业的主流,至于端到端的架构优势可谓是有一道箩筐。在优势的背后首先是原先技术范式在当前的认知下已经触及性能天花板,其次是寻找实现系统持续优化和超越人类驾驶能力上限的关键路径。

在自动驾驶发展的早期和中期,模仿学习扮演了至关重要的角色。其核心逻辑是让AI系统通过海量的传感器输入映射到人类驾驶行为,直白讲就是配对数据,学习复现人类驾驶员的决策模式。这种方法在端到端架构中尤为高效,能够用一个单一模型直接实现从原始传感器信号到控制指令的映射。系统能够快速地将人类积累的驾驶经验转化为机器可执行的策略,使自动驾驶行为更加拟人化、自然,提升了乘坐舒适性和安全性。在数据闭环的支持下,该方法能相对低成本地利用真实道路采集的数据,显著降低了基于规则的系统那高昂的开发成本。在模仿学习范式下,人类驾驶员作为AI系统的性能基准,无论是制动还是变道都是以人类驾驶员为参考目标,由此而引申出系统变道丝滑、驾驶风格稳如老司机等等很主观的描述词。然而,随着技术向深水区推进,从实际产品效果以及相关论文中可以看到模仿学习存在根本性局限性。

首先,模仿学习是一种知其然而不知其所以然的被动学习。系统只能建立输入与输出之间的统计关联,却难以理解人类驾驶员每个动作背后的因果逻辑。例如,系统学会了在某个路口减速,但它可能并不真正理解减速是因为视野盲区可能有行人,而只是机械地复制了数据中的模式。

其次,模仿学习严重受制于训练数据的分布。其性能上限本质上是被模仿对象,也就是人类驾驶员的平均水平。以前周光提过一个观点,元戎的算法能跑出来主要是依靠端到端的框架,然后再用国宾级别的人类驾驶员决策行为数据进行训练,这样就避免了大量采集数据量的不足,数据不在于多,精则灵。模仿学习无法处理训练数据中未出现过的长尾场景,更无法主动探索和优化策略以超越人类驾驶员,主要原因在于长尾场景很多事人类驾驶员也没见过甚至是没想到过,只有系统识别不了才会标记为corner cases。更为棘手的是,自动驾驶是一个典型的马尔可夫决策过程,当前微小的决策误差会在后续状态中被指数级放大,导致系统在面对数据分布之外的场景时迅速失效,系统的泛化性能很低。

Anyway,

模仿学习可以构建自动驾驶系统的性能最低限,但是上限也很明显,尤其是从自动驾驶延伸到通用AI领域更是存在天然的鸿沟。于是借鉴强化学习与大型语言模型的结合为自然语言处理带来了新的可能性。通过强化学习从人类反馈中学习RLHF,系统能够生成更加符合人类偏好和价值观的文本,可以显著提高对话系统的安全性和有用性。在自动驾驶领域,关于强化学习的探索日渐多起来了,技术路线正转向强化学习。

如果说模仿学习是系统根据人类行为而临摹字帖,那么强化学习则更像是系统内部的自主对弈,关于AI系统的对弈理念,在Andrej Karpathy最近一期访谈中也提到进化过程中充满了竞争,而对弈将推动着智能和进化。强化学习让AI智能体在虚拟或真实的环境中通过试错进行学习,采取行动后,环境会给予奖励或惩罚的反馈,智能体的目标就是学习一套能最大化长期累积奖励的策略。相比于模仿学习的范式,强化学习首先通过精心设计的多目标奖励函数,强制模型学习动作与结果之间的因果链,过滤掉数据中虚假的关联;其次是不再被动依赖既有数据,而是能利用仿真环境,主动生成和探索现实世界中罕见的corner cases,突破了模仿学习的数据覆盖瓶颈;最后是通过在仿真环境中的自我博弈和策略迭代,强化学习可以探索出人类驾驶员未曾想到或无法稳定执行的更优策略,从而实现超越人类驾驶表现的可能。

根据AK的观点,最终实现AGI的配方里,强化学习一定还是关键环节,就像人类用强化学习去塑造各种行为一样,它是工具箱里非常强大的那一件。那么对于自动驾驶领域,强化学习的有效实施,离不开一个能高保真模拟物理世界、并能高效评估策略的仿真环境。这就催生了一个新的名词或者技术应用方向,那就是世界模型和训练闭环,这也将成为当前自动驾驶研发的核心基础设施,有多少台采集车,每年采集多少bp的数据的方式将被更为高效的方法替代,产品在变化的同时制造产品的铲子也会变化。

那么,首先是为什么说强化学习的范式离不开世界模型?

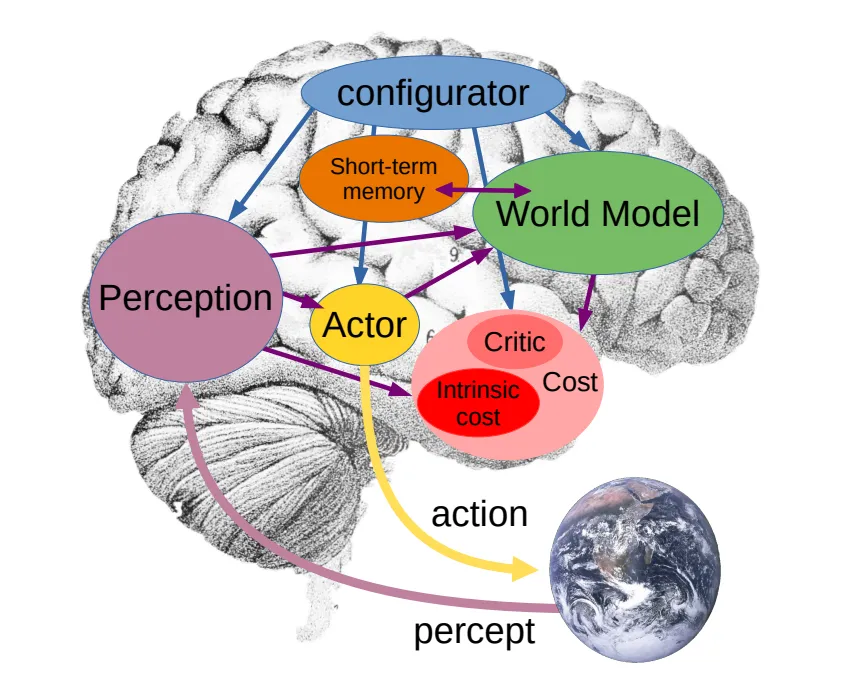

因为世界模型可以弥补强化学习的短板,传统无模型的强化学习如同盲人摸象,需在现实中经历巨量试错。世界模型则提供了一个可无限重置、加速运行的大脑内部模拟器,智能体可在此安全、高效地想象并评估行动后果,将现实试错转为思维演练。在真实世界中探索高风险动作代价巨大。世界模型创造了一个高保真的数字孪生沙盒,允许进行破坏性、极端性的安全探索,从而覆盖并解决那些corner cases。引用AK关于强化学习的比喻,通过吸管获取监督信号,导致信号/计算量比非常糟糕。通过强化学习在A任务上训练的智能体,到B环境可能完全失效。一个学习世界底层规律的世界模型,能让智能体获得举一反三的能力,应对从未见过的场景。

回到前面的对弈理念,基于模型的强化学习,是让智能体同步学习两个模型,一个是用于预测状态转移和奖励的世界模型,另一个是用于决策的策略模型。策略模型在世界模型中做梦以自我改进。你有没有发现,自己做梦的场景和现实中的会不一样,这也是一种强化学习的模拟。如果白天的场景和梦里的场景完全一致,就进入盗梦空间了,导致学习崩溃。所以,人的进化是多么的神奇。

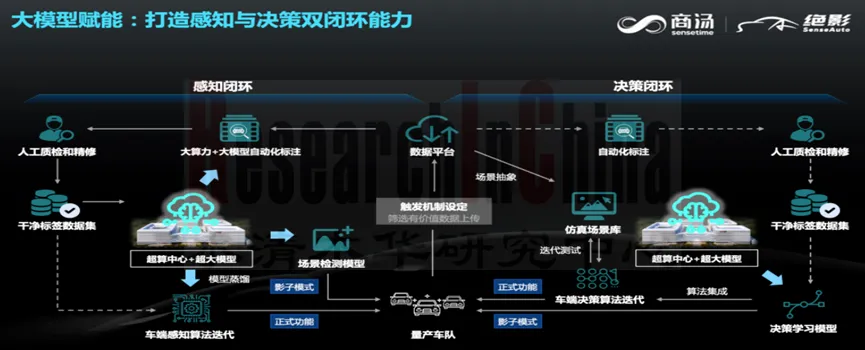

关于世界模型,理想汽车在ICCV 2025上提出,世界模型的应用包含三个层次,一是区域级仿真评估,二是合成全新数据,三是作为强化学习的世界引擎。其中,最高阶的应用便是作为世界引擎,为强化学习智能体提供一个可以无限探索、并即时获得物理正确反馈的训练场。商汤的R-UniAD的路线就是通过高质量数据进行冷启动,用模仿学习的方式训练出一个端到端基础模型,再通过强化学习方法进行训练和优化。世界模型的相关论文和派系已经漫天飞了,比较有影响力的就是李飞飞和杨立昆两个不同的观点和路径,这一块后续再详细分解一下。

其次是训练闭环。从数据闭环到训练闭环的演进,虽然都是闭环,但是核心理念有着天然的不同,不会还有自动驾驶企业数据闭环都没做好吧?现在训练闭环又来了,数据闭环是问题驱动,从路上采集数据发现问题、人工处理标准后训练模型、打补丁重新部署模型,这种模式发现corner cases的成本很高并且效率低。而训练闭环是让系统在仿真中自我发现问题、优化策略,也是一种对弈的体现。

在此范式下,系统在云端世界模型中主动构造挑战性场景,让驾驶策略模型与环境持续交互,并根据奖励函数自动优化,再将优化后的策略部署到车端。说白了就是是让自动驾驶系统从一个需要工程师手把手喂养数据的学生,转变为一个能够在虚拟世界中自学成才的自主智能体,华为的WEWA架构已经超过数据闭环,而是一种训练闭环的模式。

强化学习的崛起标志着人工智能领域的一个重要转折点。意味着AI系统从主要关注模式识别和预测,转向关注决策与行动。这一转变不仅打开了解决复杂现实问题的新途径,也使我们更接近创造具有自主学习和适应能力的智能系统的目标。大型预训练模型已经展现了强大的世界知识和推理能力。将强化学习与这些基础模型相结合,可能会创造出更加强大、适应性更强的智能系统。当然,随着世界模型的完善,构建能够准确预测环境动态的世界模型,将使强化学习智能体能够在内部模拟中进行思考和规划,将会大幅提高学习效率和安全性。

当前的强化学习系统通常在特定任务上训练,完成任务后学习过程基本停止。训练闭环系统将能够持续学习,在不断变化的环境中积累经验并调整策略。

除此之外,强化学习将越来越多地用于开发能够与人类有效协作的智能系统,理解人类意图,适应人类偏好,并在必要时向人类学习或寻求指导,所以伦理对齐也会是一个重要的课题。

感谢,每一次阅读都是作者前进的动力,每一次点赞都是加油站!