AAAI2026 | 自动驾驶世界模型大突破!SparseWorld用稀疏查询实现7倍提速+40%预测精度飙升

- 2026-02-03 01:45:19

AI前沿论文和idea分享知识星球包含本文2个改进idea。

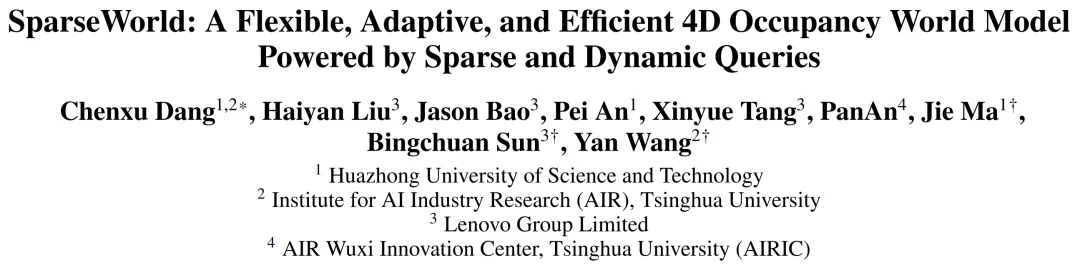

标题:SparseWorld: A Flexible, Adaptive, and Efficient 4D Occupancy World Model Powered by Sparse and Dynamic Queries

开源代码:https://github.com/MSunDYY/SparseWorld

论文下载地址:https://arxiv.org/pdf/2510.17482

在自动驾驶技术的演进中,世界模型(World Model)扮演着核心角色——它需要基于历史观测精准预测未来场景动态,并为轨迹规划提供可靠支撑。

语义占用(Semantic Occupancy)作为一种强大的场景表示方式,因能捕捉丰富的空间语义信息,已成为世界模型的主流选择。

然而,现有占用世界模型普遍依赖静态固定的嵌入或网格结构,不仅限制了感知的灵活性,其“原位分类”(in-place classification)范式也与真实场景的动态连续性存在本质错位。

为此,来自华中科技大学、清华大学AIR实验室与联想集团的团队提出了SparseWorld——一款基于稀疏动态查询(Sparse and Dynamic Queries)的4D占用世界模型。它以灵活性、自适应性和高效性为核心优势,在感知、预测和规划任务中均达到了当前最优性能。

一、现有方法的三大核心痛点

在深入SparseWorld之前,我们先梳理现有占用世界模型的关键局限,这也是SparseWorld的创新出发点:

1. 感知灵活性不足

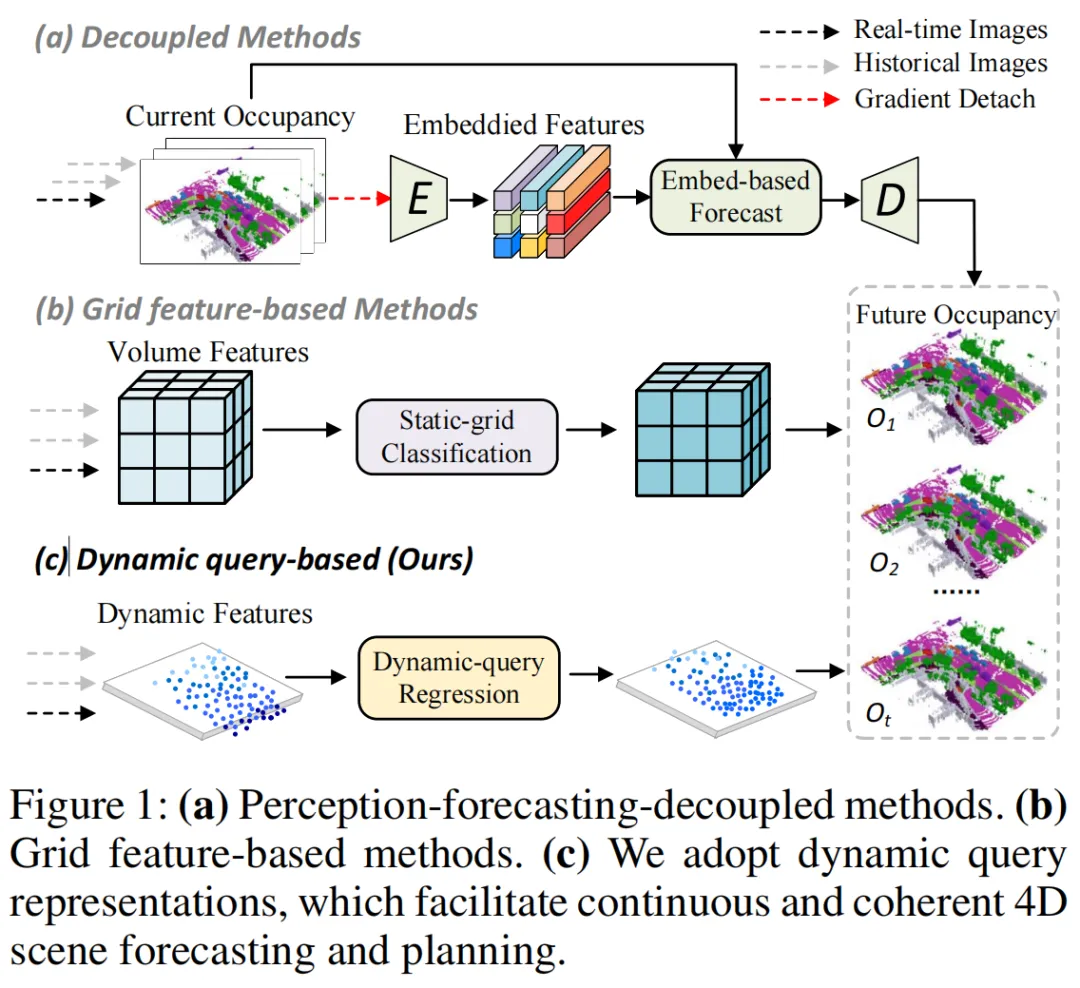

早期解耦式方法(如上图(a))将感知与预测分离,通过独立编码每一帧占用状态再融合预测,导致梯度流动受阻,难以端到端优化;而近期的网格特征方法(如上图(b))虽实现了端到端训练,但依赖人工预定义的空间范围,无法适应自动驾驶中车速剧烈变化的场景——高速行驶时需要更远的感知范围,低速泊车时则需聚焦近处细节,固定范围设计会导致预测精度下降或计算资源浪费。

2. 动态连续性错位

现有grid-based方法采用“原位分类”策略,即对每个网格单元预测其未来是否被占用。这种离散化的预测方式与车辆运动、场景动态的连续性本质相悖,容易引发时间不一致性、特征漂移和累积误差,尤其在长时预测任务中表现突出。

3. 计算效率低下

密集网格表示需要处理海量冗余信息(物理世界本质是稀疏的),导致计算量和内存开销巨大,难以满足自动驾驶的实时性要求。

二、SparseWorld的核心设计与技术原理

SparseWorld的核心思想是:用稀疏动态查询替代密集网格,通过 ego 车辆状态引导感知范围自适应调整,以回归导向的预测范式捕捉场景动态连续性,并设计针对性训练策略保障模型高效收敛。

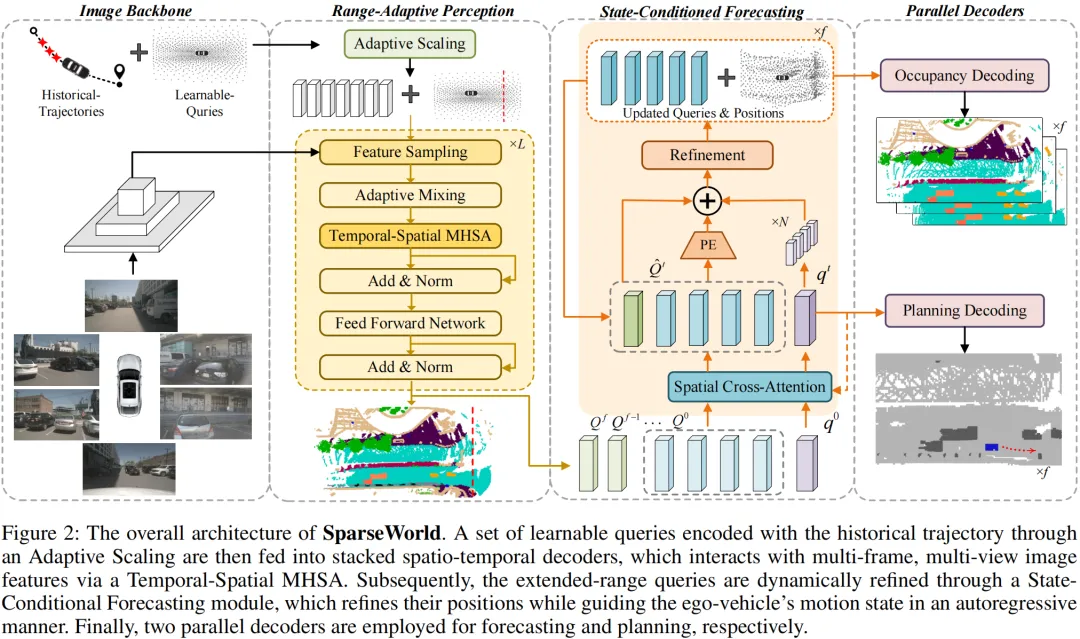

其整体架构如下图所示,主要包含四大模块:图像骨干网络、范围自适应感知模块、状态条件预测模块和并行解码头,辅以时间感知自调度训练策略。

1. 范围自适应感知模块(Range-Adaptive Perception, RAP)

RAP模块的核心目标是实现“车速感知范围自适应”——根据ego车辆的历史运动状态,动态调整查询的空间分布,从而匹配不同行驶场景的感知需求。

(1)输入设计:稀疏动态查询

RAP的输入是可学习查询嵌入(Learnable Query Embeddings)及其对应的4D坐标(x, y, z, timestamp)。与密集网格相比,稀疏查询具有三大优势:

灵活性:自适应空间分布支持超远距离感知; 连续性:与真实场景的时空动态特性天然对齐; 高效性:大幅降低存储和计算开销。

(2)自适应缩放子模块(Adaptive Scaling)

根据驾驶直觉:车速越快,所需感知范围越远。该子模块通过编码ego车辆的历史轨迹(隐含当前速度信息),调制查询的初始坐标分布:

其中, 是初始查询坐标(可学习), 是历史轨迹点, 是调制后的查询坐标。这一设计使查询的空间分布能随车速动态调整——高速时查询向远处扩展,低速时聚焦近处细节。

(3)时空多头自注意力(Temporal-Spatial MHSA)

为捕捉查询间的时空关联,RAP采用堆叠解码器结构,每层解码器包含时空多头自注意力(TSMHSA)。其注意力分数由三部分组成:语义相似度、空间邻近性和时间因果性,公式定义如下:

其中:

是查询嵌入, 是3D坐标; 是可学习缩放因子,用于控制空间偏置; 是时间掩码,避免未来查询干扰当前感知:

TSMHSA确保了查询能在时空维度上有效交互,同时通过时间掩码维护了感知的因果一致性。

2. 状态条件预测模块(State-Conditioned Forecasting, SCF)

SCF模块的核心创新是用回归替代分类,将占用预测转化为查询的动态偏移回归任务,从而更好地捕捉4D场景的连续演化。

(1)Ego查询与场景查询交互

SCF将ego车辆状态编码为ego查询,通过空间交叉注意力(Spatial Cross-Attention)与场景查询交互,实现ego状态对预测的引导:

其中, 是t时刻ego查询, 是场景查询, 是4D位置编码,用于补充时空信息。这种交互方式使模型能同时捕捉ego车辆的全局运动和每个场景查询的局部动态。

(2)回归导向的动态预测

与grid-based方法的“原位分类”不同,SCF通过回归查询的动态偏移来预测未来场景:每个查询会预测下一时刻的3D位置偏移,而非判断该网格是否被占用。这种回归范式天然契合场景动态的连续性,有效缓解了时间不一致性和累积误差问题。

3. 时间感知自调度训练策略(Temporal-Aware Self-Scheduling)

SparseWorld的多阶段、多输出特性给训练带来挑战——如何为查询分配合理的时间戳,确保不同时刻的预测能得到有效监督?团队设计了时间感知自调度训练策略,分为两个阶段:

(1)预训练阶段(6个epoch)

不明确分配查询时间戳,暂时移除TSMHSA中的时间项,通过Chamfer距离和Focal损失监督查询位置和语义分类:

其中, 是Chamfer距离,用于监督查询位置与真实占用的匹配度; 是解码器输出的语义标签, 是真实标签。

(2)端到端训练阶段(48个epoch)

构建统计矩阵 ,记录每个查询在不同时间戳上的预测贡献,通过“最大比例优先分配”算法自动为查询分配时间戳。训练过程中,统计矩阵和查询时间戳每个epoch动态更新,总损失定义为:

其中, 是预测的查询位置, 是预测的轨迹点, 是真实轨迹。

该策略避免了人工分配时间戳的主观性,同时通过动态调整实现了高效稳定的训练,仅需 次Chamfer距离计算(传统方法需 次)。

三、实验

团队在Occ3D-nuScenes基准数据集上进行了全面实验,从预测精度、规划安全性和推理效率三个维度验证了SparseWorld的优势。

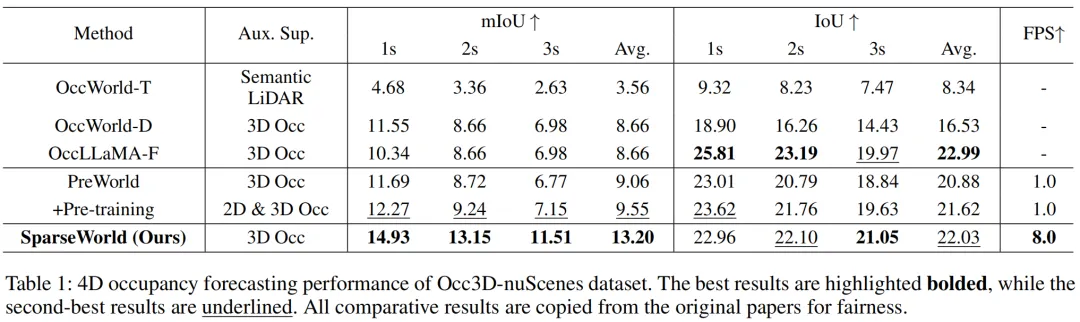

1. 4D占用预测性能

下表展示了SparseWorld与现有主流方法的对比。可以看到:

SparseWorld的平均mIoU达到13.20,比当前最优的PreWorld提升20%-40%; 在长时预测(3s)中,SparseWorld的mIoU为11.51,远高于PreWorld的6.77,体现了其在时间一致性上的优势; 推理速度达到8.0 FPS,是PreWorld(1.0 FPS)的7倍,大幅提升了实时性。

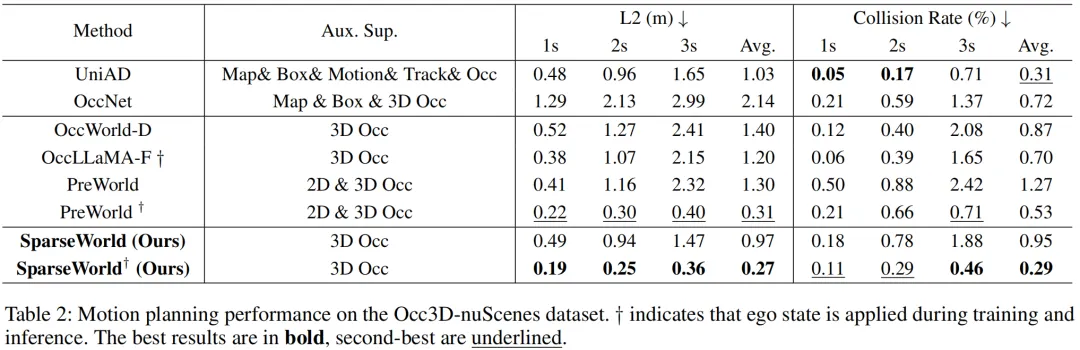

2. 轨迹规划性能

下表展示了运动规划任务的结果,SparseWorld在碰撞率和轨迹精度上均表现出色:

平均碰撞率仅为0.29%,是PreWorld(0.53%)的一半,大幅提升了行驶安全性; 平均L2误差为0.27m,优于多数对比方法,体现了精准的轨迹预测能力。

四、可视化与直观验证

除了定量指标,可视化结果更能直观体现SparseWorld的优势:

1. 长时预测连续性

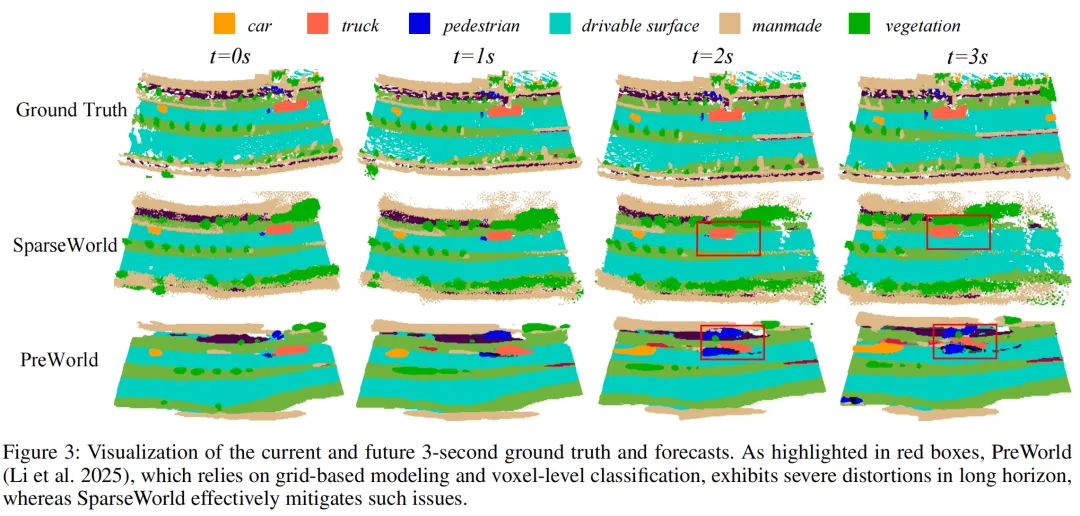

上图对比了SparseWorld与PreWorld在3秒长时预测中的表现。可以看到:

PreWorld(grid-based方法)在长时预测中出现明显的特征畸变(红色框标注),尤其是车辆、行人等前景目标; SparseWorld通过动态查询回归,有效保持了场景结构的连续性,前景目标的形状和位置预测更精准。

2. 中间特征可解释性

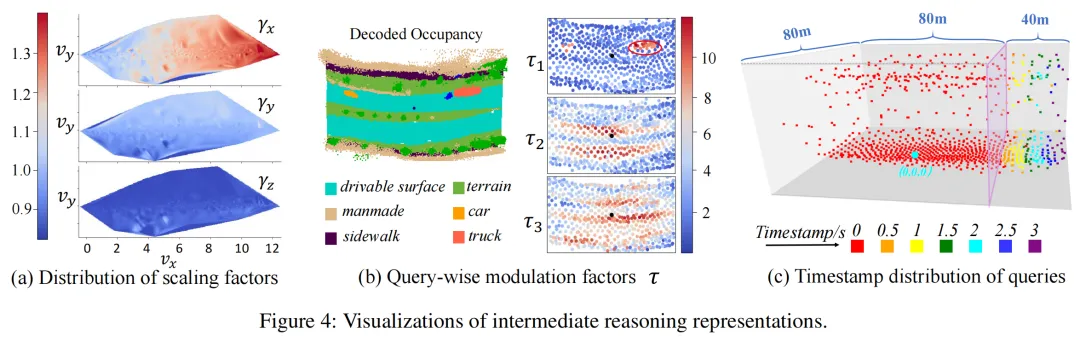

上图展示了SparseWorld的中间推理过程:

图4(a):缩放因子随纵向车速的变化趋势——车速越快,越大,验证了感知范围的自适应特性; 图4(b):查询调制因子的注意力分布——聚焦前景目标,关注可行驶区域,体现了模型的结构化推理能力; 图4(c):查询的时间戳分布——沿纵向呈现清晰的层次结构,支持长距离感知与跨时间预测。

五、总结

SparseWorld通过稀疏动态查询这一核心设计,突破了传统密集网格模型的局限,在自动驾驶的4D占用预测与规划任务中实现了性能与效率的双重飞跃。其核心贡献可概括为三点:

提出范围自适应感知模块,通过ego状态调制查询分布,实现感知范围的动态调整; 采用回归导向的状态条件预测范式,解决了静态分类与场景动态的错位问题; 设计时间感知自调度训练策略,保障了模型的高效稳定收敛。

愁论文、缺idea?每天推送6篇开源论文+创新思路,助你突破科研瓶颈

AAAI2026 | 颠覆暗光修复!无参考也能同时做图像增强+去模糊,VAR-LIDE刷新SOTA

AAAI2026 | SD-PSFNet:9.6M 参数量横扫图像去雨榜单,物理建模+序列化融合太顶了

AAAI2026 | 突破模态鸿沟+数据稀缺双重困境!KTCAA框架在草图ReID领域实现SOTA

告别源域数据依赖:HEAL凭 "无学习" 设计,攻克跨模态医学图像分割难题

AAAI2026 | CADTrack用线性复杂度交互+可变形对齐,刷新可见光红外目标跟踪新高度

AAAI2026 | 突破可见光红外ReID瓶颈!Signal框架凭选择性交互+全局局部对齐登顶三大基准

AAAI2026 | 突破模态壁垒!FVMGN用频率域建模+视觉语言融合,刷新遥感图像分类上限

AAAI2026 | 联邦医学图像分割大突破!FedBCS凭频域校准+双级对齐,刷新SOTA性能

AAAI2026 | Sim4Seg打通医疗影像“分割+ 诊断”双任务,5大模态+10类疾病全覆盖!

AAAI2026 | DSANet的自引导建模+语义对齐双杀技成就弱监督视频异常检测天花板!

AAAI2026 | SAM-DAQ:用并行适配器+查询记忆刷新RGB-D视频显著目标检测记录

突破弱光检测瓶颈!FreDFT:频域Transformer重构可见光-红外目标检测,检测精度飙升

AAAI2026 | 红外目标检测天花板来了!TDCNet凭TDC模块+注意力机制,性能炸裂

实时目标检测天花板!RF-DETR突破60AP,NAS让Transformer又快又准

计算机视觉Paper with code-2026.1.30

计算机视觉Paper with code-2026.1.28

计算机视觉Paper with code-2026.1.27

CV计算机视觉微信群

群内包含目标检测、图像分割、目标跟踪、Transformer、多模态、NeRF、GAN、缺陷检测、显著目标检测、关键点检测、超分辨率重建、SLAM、人脸、OCR、生物医学图像、三维重建、姿态估计、自动驾驶感知、深度估计、视频理解、行为识别、图像去雾、图像去雨、图像修复、图像检索、车道线检测、点云目标检测、点云分割、图像压缩、运动预测、神经网络量化、网络部署等多个领域的大佬,不定期分享技术知识和内推招聘信息。

CV计算机视觉 交流群

CV计算机视觉 交流群