让无人车学会“社交”,具身交互智能使自动驾驶真正成为现实!

- 2026-02-02 10:57:28

在无人驾驶领域,车道跟踪、车辆流量监控、变道辅助及车道保持等技术已得到广泛应用。但无人驾驶系统仍面临一个根本性挑战:构建人与车之间的双向认知协同。无人车不仅需要准确理解人类行为,其决策也需能被人类及时理解,二者缺一都会损害可信性。

为此,无人车必须具备深度的情境理解、自然的交互、持续的学习能力,才能建立真正的可信赖性。然而,驾驶场景是高度动态、碎片化且无穷尽的,因此,无人车如何在这些日益复杂的真实场景中实现持续进化,构成了其迈向真正智能化的最后一道难关。

近日,清华大学李德毅和北京工业大学马楠作为通讯作者在中国工程院院刊《Engineering》期刊上发表“无人驾驶具身交互智能”的研究论文,提出了无人驾驶具身交互智能理论框架,通过跨媒体感知、机器学习、认知计算和生成式人工智能等技术,构建与物理世界统一的智能表达与学习方法。

该研究创新性地构建了端到端感知-认知-行为闭环反馈范式,使无人车不仅能交互、会学习、可信任,更能在日常驾驶中遇到的每一个碎片化场景中进行自主终生学习。通过自学习、自成长能力,以有限的驾驶经验逼近无限的智能,从而增强机器的智能化水平,真正实现人机融合,使无人车具备情境理解能力,为大众所接受。

▍从感知到交互认知:无人驾驶如何理解人、车与环境?

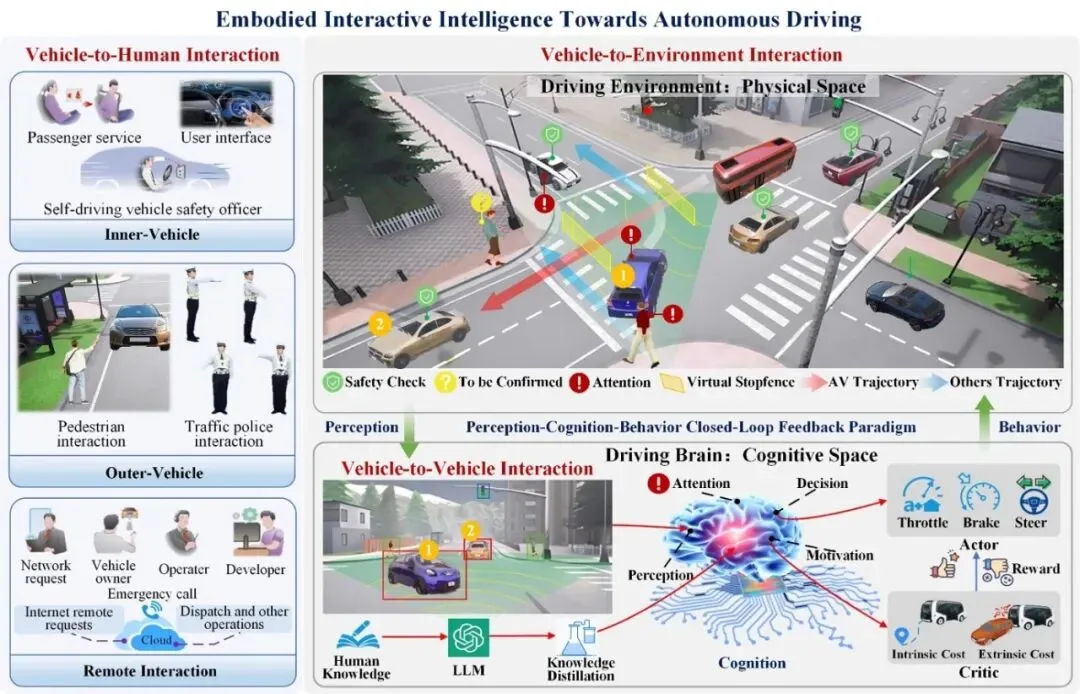

要应对复杂交通环境,无人驾驶系统需要超越传统的被动“感知”,迈向主动的“交互认知”。本研究提出的无人驾驶具身交互智能框架(Embodied Interactive Intelligence Towards Autonomous Driving, EIIAD),正是这一跨越的核心。

该框架的核心思想是:无人车如同一个置身于交通环境中的智能体,它利用跨模态感知系统识别物理世界的关键要素,并通过主动与环境交互来获取反馈。基于此,它持续构建并优化物理世界与自身认知世界的映射关系,最终形成“感知-认知-行为”的闭环范式,实现近似人类的决策与控制能力。

根据交互对象差异,无人驾驶具身交互智能包括车与人交互、车与车交互和车与环境交互三大类别。针对不同交互主体的行为特征差异,本研究提出了差异化的交互认知模型:

理解人:如何预判行人的意图?

针对车与人交互,研究提出基于多视时空特征的超图神经网络(Hypergraph Neural Network based on Multi-view Spatial-temporal Features, HGNN-MSTF)。该模型通过构建动态时空超图捕捉人体关节的高阶语义关联,融合多视角跨模态感知信息提取并学习基于场景上下文空间位置的行人动作特征,实现对行人意图的精准理解(图1b);

理解车:如何与其他车辆安全博弈?

针对车与车交互,研究设计了基于联合轨迹预测的世界模型深度强化学习网络(Deep Reinforcement Learning - Joint Trajectory Prediction World Model, DRL-JTPWM)。该模型的核心在于,它并非仅预测单一车辆的轨迹,而是通过估计无人车与周围社会车辆行驶轨迹的联合概率分布,推理多个潜在交互场景,利用预测的未来场景评估驾驶策略优劣,在狭路会车、超车并道、无保护路口左转等复杂交互工况中展现出优异性能(图1c);

理解环境:如何构建统一的交互认知?

在前两者的基础上,本研究将上述车与人的交互认知及环境约束集成于统一的人车在环深度强化学习框架,从而构建了端到端统一约束的车与环境交互模型(Unified Constrained Vehicle–Environment Interaction, UniCVE)。

具体而言,就是采用鸟瞰图空间统一编码多视角跨模态感知信息,通过超图神经网络学习环境要素间的高阶关系,并创新性地将大语言模型的驾驶知识蒸馏到实时模型中,统一表达了无人车与环境中各要素相互关联的复杂交互行为,实现了真正意义上的系统性环境理解。

图1 无人驾驶的具身交互智能。(a)无人车与环境交互:驾驶环境复杂性主要源于动态变化的路况,罕见的危险场景以及多样化的地形和气候条件等。(b) 无人车与人的肢体语言交互方法:基于时空超图的跨模态动作识别。 (c) 车体语言交互:包括狭路会车,超车并道和无保护十字路口多车交互等工况。

▍实现跨越:从模拟验证到万公里路测的交互智能闭环

本研究构建了一个端到端的感知-认知-行为闭环反馈框架。该框架的核心创新在于,它将自动驾驶汽车与不同交通参与者(人、车、环境)的复杂交互理解,整合为统一的奖励函数与软约束,从而使车辆能够以符合社会规范、可预测且安全的方式进行决策与行驶。

通过强化学习范式,该模型具备了持续学习与自我提升的能力。在模拟环境中,其交互智能已超越多种先进算法,展现出更接近人类的驾驶熟练度。

更具里程碑意义的是,该框架已通过大规模真实路测的验证。研究团队将最终集成的UniCVE模型 部署于东风无人驾驶巴士,在雄安新区复杂开放道路上,累计安全行驶超过22,000公里,完成了45,000次导航任务。此次成功部署,标志着该具身交互智能框架走出了仿真,迈向了现实应用。

尤为可贵的是,路测不仅证明了其有效性,也揭示了进化的方向。在存在严重视觉遮挡的路口等极端场景中,模型初期会表现出反应延迟。但研究发现,通过在特定高风险路口反复接触类似模式,模型能基于经验记忆发展出预判能力,实现主动安全适应。

这证明,该研究所提出的具身交互智能范式,使无人车具备了在碎片化场景中的自主终生学习机制,构建了从有限样本到无限智能的演化路径,为无人驾驶系统实现真正"懂人情世故"的社会化融入提供了理论支撑与技术路径,标志着无人驾驶技术从功能实现向认知智能的跨越式发展。未来,团队将着力增强模型对遮挡的感知能力、融入不确定性预测,并强化其记忆模块,以更好地应对各类复杂路口几何形状。

论文链接:https://doi.org/10.1016/j.eng.2025.09.032

▍主要作者简介:

马楠,北京工业大学人工智能学院院长,教授,博士生导师,入选2024年教育部长江学者奖励计划,青年北京学者,国家重点研发计划项目首席科学家,智能感知与自主控制教育部工程研究中心副主任,中国人工智能学会副秘书长,北京市智能制造与机器人技术创新专项负责人,北京市先进工作者。研究方向为交互认知、具身智能、无人驾驶与智能机器人。以第一完成人先后获得中国图象图形学学会科技进步一等奖、中国电子学会科学技术奖【技术发明类】二等奖;已在IEEE TPAMI、TRO、TIP、TNNLS、TMM、中国科学.信息科学、ACM MM、AAAI、ICRA等国内外学术期刊、会议上发表论文百余篇。

李德毅,中国工程院院士,国际欧亚科学院院士,中国人工智能学会名誉理事长,军事科学院研究员,清华大学博士生导师。先后获得国家科技进步二等奖1项、三等奖2项,部级科技进步一等奖3项、二等奖4项,荣获2020年吴文俊人工智能最高成就奖,主编技术丛书7本。

如需咨询企业合作事宜,欢迎联系机器人大讲堂-客服(19560423866,手机与微信同号)进行对接。

----------------END-------------------

工业机器人企业

埃斯顿自动化 | 埃夫特机器人 | 非夕科技 | 法奥机器人 | 越疆机器人 | 节卡机器人 | 松灵机器人 | 珞石机器人 | 盈连科技 | 集萃智造 | 优傲机器人 | CGXi长广溪智造 | 阿童木机器人 | 极智嘉 | 海康机器人

服务与特种机器人企业

亿嘉和 | 晶品特装 | 七腾机器人 | 史河机器人| 九号机器人 | 普渡机器人 | 小笨智能 | 机器姬 | 施罗德机器人

医疗机器人企业

元化智能 | 天智航 | 思哲睿智能医疗 | 精锋医疗 | 佗道医疗 | 真易达 | 术锐®机器人 | 罗森博特 | 磅客策 | 柏惠维康 | 迪视医疗 | 水木东方|康诺思腾

人形机器人企业

优必选科技 | 宇树 | 云深处 | 星动纪元 | 伟景机器人 | 逐际动力 | 乐聚机器人 | 大象机器人 | 魔法原子 | 众擎机器人 | 帕西尼感知 | 赛博格机器人 | 数字华夏 | 理工华汇 | 傅利叶智能 | 天链机器人 | 开普勒人形机器人 | 灵宝CASBOT | 清宝机器人 | 浙江人形机器人创新中心 | 动易科技 | 智身科技 | PNDbotics |卓益得机器人| 鹿明机器人 | 擎朗智能| 伽利略GALILEO

具身智能企业

跨维智能 | 银河通用 | 千寻智能 | 灵心巧手 | 睿尔曼智能 | 微亿智造 | 推行科技 | 中科硅纪 | 枢途科技 | 灵巧智能 | 星尘智能 | 穹彻智能 | 方舟无限 | 科大讯飞 | 北京人形机器人创新中心| 国地共建人形机器人创新中心 | 戴盟机器人| 视比特机器人| 星海图 | 月泉仿生 | 零次方机器人 | 中科深谷 | 智平方 | 大咖机器人 | 灏存科技 | 具识智能| Xynova曦诺未来

核心零部件企业

绿的谐波 | 因时机器人 | 坤维科技 | 脉塔智能 | 青瞳视觉 | 本末科技 | 鑫精诚传感器 | 蓝点触控 | BrainCo强脑科技 | 宇立仪器 | 极亚精机 | 思岚科技 | 神源生 | 非普导航科技 | 锐驰智光 | NOKOV度量科技 | 因克斯 | 褔德机器人 | 巨蟹智能驱动 | 微悍动力 | 凌云光 元客视界 | 璇玑动力| 意优科技| 瑞源精密 | 灵足时代 | HIT华威科 | 星汇传感

教育机器人企业

加入社群

欢迎加入【机器人大讲堂】读者讨论群, 共同探讨机器人相关领域话题,共享前沿科技及产业动态,添加微信“robospeak2018”入群!

看累了吗?戳一下“在看”支持我们吧