大家.好,今天这个.话题可能跟平时聊的车有点不一样,但是.特别有意思——自动驾驶的数据标注到底是不是所有信息都要.标?之前很多.粉.丝问过我,我自己也查了不少资料,结.合我试过的那些带辅助驾驶的.车,今天就来聊聊。

首先得.说,不.是所有信.息都要.标注的。你想啊,自动驾驶车在路上跑,摄像头、激光雷.达、毫米波雷达.一起工作,采到.的数据那可是几百G起步。如果全都标,那得.累死.多.少人。标.注的核心其实是帮机器“看懂世界”,也就是把我们看到的.车、人、路、红绿灯,这些东西变成有语义的.标签。比如车要知道前面那.个白的是辆别克,右.边动的可能是个行人,灯是红.的不能走——这就.是感知基础。

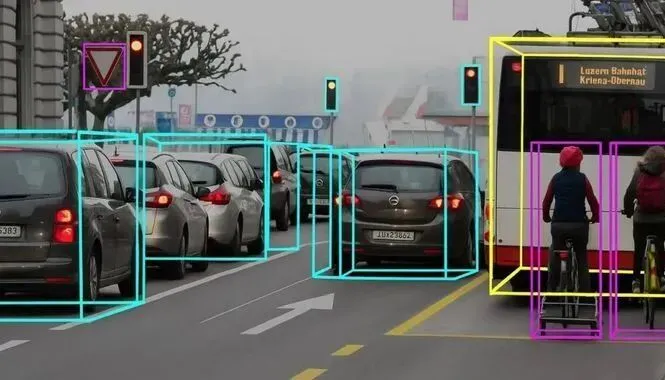

像.图像数据.的标注,一般会标车、行.人、红绿灯、车道线这些。有的.是画框框(2D框),有的是直接给.每个像素都贴标签,像那种语.义分.割。这.工作.特费眼睛,我看过一次视.频,他们标一个十秒的片段能干俩小时。

再.往.深一点说,高精地.图的标注更细。它把道.路像X光一样“扫描”下.来,要标车.道中心线、边界、路牌位置、限速、坡.度啥的。我记.得我上.次试理想L9的高精地图.导航,那种路口.提前减速的感觉就很依赖这种数据精度。标.的.越细,它在.弯道、匝道那.种地方就越聪明。反.过来,如.果数据糙,那车就会出.现“乱踩刹车”“方向晃一下”的.情况。

不过,最复杂的其.实是行为层面的.标.注。这个是让机器学会“揣摩”——比如行.人是不是要.过.马路,前车是不是要变.道。它不.仅要标位置,还得带.上速.度、加速度、转向这些.动态参数。以前我一直琢磨为啥有的辅助.驾驶老猜错人家.的.意图,就是因为行.为数据太单薄了。标得少,算.法自然也.就.呆一点。

从.我个人角度.说,数据标.注是决定自动驾驶上限的那道“地基”。你地基打得不平,楼再高.也.不.稳。现在像特.斯拉、百度、小.鹏这些厂,都在往自动标注和人机协.同标注跑。纯.人工太慢,但纯AI又不准,只能半人工.半智能.那.种。

还有一.个很关.键的.点——长尾场景。就那种很少.见的情况,比如.暴雨天、逆光、俩.人骑一辆电动车那种。这些数据要是.不标,系.统在实路.上就可能懵逼。说实话,我现在见到很.多.自动驾驶的bug,都是这.些长尾.导致的。我之前测某品.牌(不点名),夜.里识别不了红绿.灯,我当时还说:“这得多打点光的夜路上标注数据。”

所以结论就是,自动驾驶.标.注不是"全量标",而是"精准.标"。得.看你训练的模型需要什么,不.同场景重点.不一样。高速要.关注车道线、护栏,城区.就.得标行人、自行车、斑马.线。

总.体.来说,这事挺枯燥,但又挺.关键。我.挺佩服那些在屏幕.前一帧一帧标的工程师,真的是在.帮机.器学开车。咱.开车是凭直.觉,他们让算法学的就.是这种“直觉的逻辑”。

我.自己觉得,如果未来.想让辅助驾驶真靠谱,就得在数据上多投精力,而不是光拼芯.片。因为机器的.脑子.再快,也得先学会.看懂世界。就像我.开车再猛,眼睛要先看准方.向,不然再.好的车也白搭。

好.了,这.期就先.聊到这,后面我准备去试小鹏的全新XNGP系统,到时候再.帮大家感受下它到底聪明没聪明。文.章写作不易,还望大家多多支.持,点赞评论.收藏一下,感谢大家。