告别“人工智障”?万字拆解全自动驾驶的终极架构与认知革命

- 2026-02-07 11:35:33

当你的车在施工区被“困住”,或者无法为救护车让路时,你才意识到:99%的自动驾驶系统,其实只是“高级地图跟随器”。

深夜,一辆Cruise自动驾驶出租车缓缓驶入一条看似寻常的街道。前方,施工队刚刚铺设的混凝土尚未凝固。车辆传感器“看到”了前方的“道路”,但无法理解“未干混凝土”这个物理概念。结果?车辆径直驶入,轮胎深陷,动弹不得——这一幕真实发生在2023年的美国街头。

另一边,特斯拉的视觉系统在复杂路口“失明”,撞上了横穿马路的行人;Waymo的车辆在遇到鸣笛的急救车辆时,无法像人类司机一样迅速让出车道。

这些不是偶发故障,而是当前自动驾驶架构的“系统性盲区”。

为什么投入数千亿研发的自动驾驶,依然会被现实世界的“长尾问题”轻易击败?为什么模块化堆栈在实验室表现优异,上路后却频频“翻车”?

今天,我们将深入一篇重量级综述论文的核心,为你揭示:从“模块化拼装”到“类人认知”,全自动驾驶必须跨越的三大鸿沟,以及一个颠覆性的SO-M-E2E架构如何成为破局关键。

读完本文,你将彻底理解:

1. 当前自动驾驶的“阿喀琉斯之踵”:模块化架构为何必然失败? 2. 认知革命的“三级跳”:态势感知如何从“看到”进化到“理解”? 3. 终极架构的“设计蓝图”:SO-M-E2E如何融合模块化与端到端的优势? 4. 落地应用的“可行路径”:从数据驱动到法规适配的全链条解决方案。

❓ 核心痛点:为什么你的自动驾驶总是“翻车”?

让我们先看一组残酷的数据对比:

• 实验室精度:在KITTI、nuScenes等标准数据集上,顶尖自动驾驶系统的目标检测精度超过98%,跟踪误差低于0.5米。 • 现实世界表现:面对未干混凝土、特殊交通标识、突发性行人行为等“边缘案例”,系统失效概率陡增至无法量化——因为训练数据中根本没有这些场景。

这就是当前自动驾驶面临的最大悖论:系统在已知领域接近完美,在未知领域却如同“盲人”。

痛点一:模块化架构的“信息衰减链”

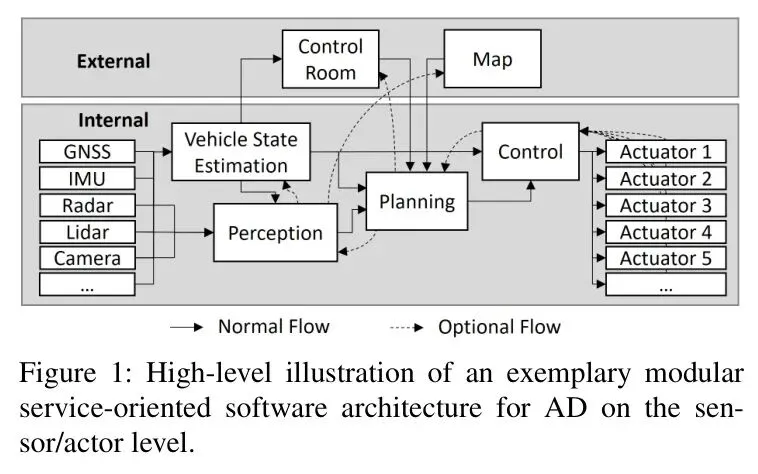

当前主流的自动驾驶堆栈,如图1所示,是一个典型的模块化、面向服务的架构。

这种架构的逻辑很清晰:感知模块(Perception)负责“看世界”,生成环境模型;预测模块(Prediction)推测其他交通参与者的意图;规划模块(Planning)基于以上信息,计算出一条安全、舒适的轨迹;最后由控制模块(Control)执行。

听起来很合理,对吗?但问题就出在模块之间的硬编码接口上。

每个模块都像一个“黑匣子”,它只输出设计者预先定义好的信息格式。例如,感知模块可能只输出“车辆、行人、车道线”的边界框和类别。至于“右侧有一所学校,此时刚放学”这样的上下文信息,在模块化架构中根本无法传递。

这就导致了一个致命问题:信息在传递过程中不断衰减和失真。原始传感器数据中蕴含的丰富语义,在经过层层抽象后,只剩下干瘪的几何和类别标签。规划模块拿到的,是一个被严重“降维”的世界。

痛点二:态势感知的“认知天花板”

人类司机是如何开车的?我们不仅仅是在“识别物体”,更是在理解场景。

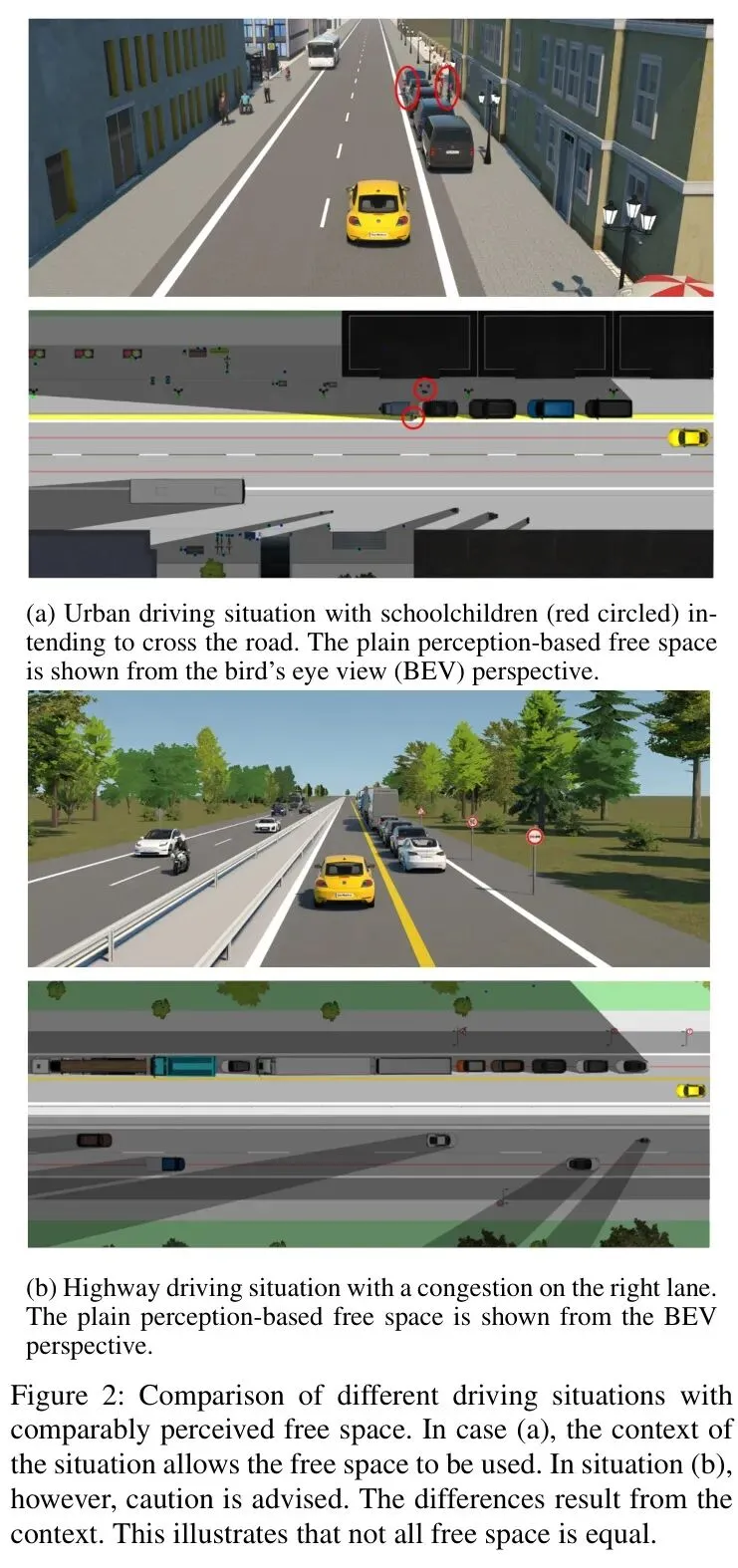

看图2中的两个场景:

图2a中,基于普通感知的“可行驶空间”(蓝色区域)似乎很清晰。但人类司机一眼就能看出:右侧是学校,左侧校车在等待,正值放学时间,儿童可能随时从停放的车辆间穿出。因此,这里的“可行驶”是有条件的,必须低速、谨慎通过。

图2b中,同样是“可行驶空间”,但这是在高速拥堵的右侧车道,规则明确,可以相对放心地行驶。

这两种场景对感知模块的输出可能完全一样,但对决策的要求却天差地别。这就是二级态势感知(Level 2 SA)——对意义的理解——的缺失。当前的系统大多停留在一级态势感知(Level 1 SA),即“看到了什么”,而无法进阶到“这意味着什么”。

痛点三:开放世界的“长尾分布”噩梦

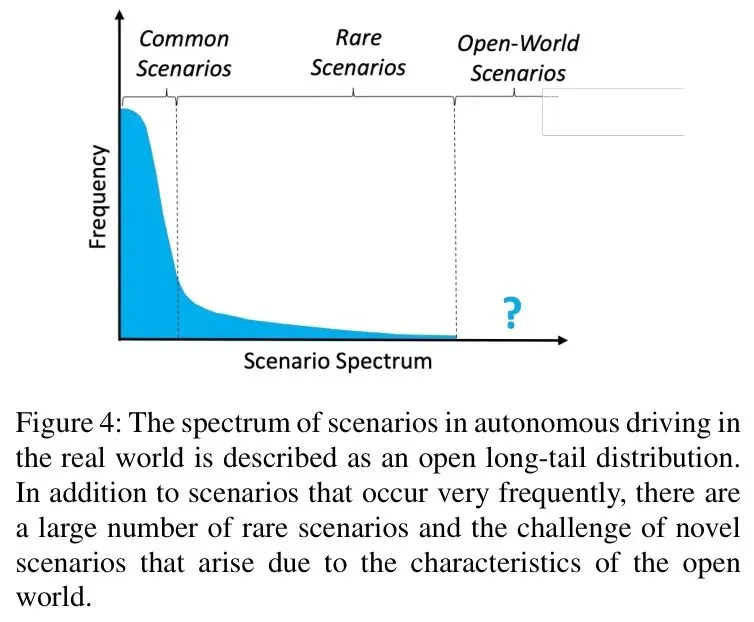

现实世界的驾驶场景服从一个开放的长尾分布。

这意味着,99%的常见场景,系统可能已经处理得很好。但剩下的1%,包含了无数种千奇百怪的“边缘案例”(Edge Cases):动物突然窜出、道路临时施工、特种车辆通行、极端天气、奇葩的交通管制……

传统的解决思路是“打补丁”:遇到一个新问题,就开发一个新模块或新规则。但结果是,系统变得越来越臃肿,变成了一个由无数专家规则拼凑起来的“弗兰肯斯坦”,失去了应对未知的灵活性和泛化能力。

但为什么99%的优化尝试都失败了?关键就在于,我们一直在用“硬编码”的思维,去解决一个需要“软连接”和“认知理解”的问题。

为了帮你快速把握破局之道,我们先看这张核心架构演进思维导图——

接下来,我们逐层拆解这张图中的每个关键模块,看看真正的认知革命是如何发生的。

🧠 架构演进:从“硬连接”到“软编排”的认知跃迁

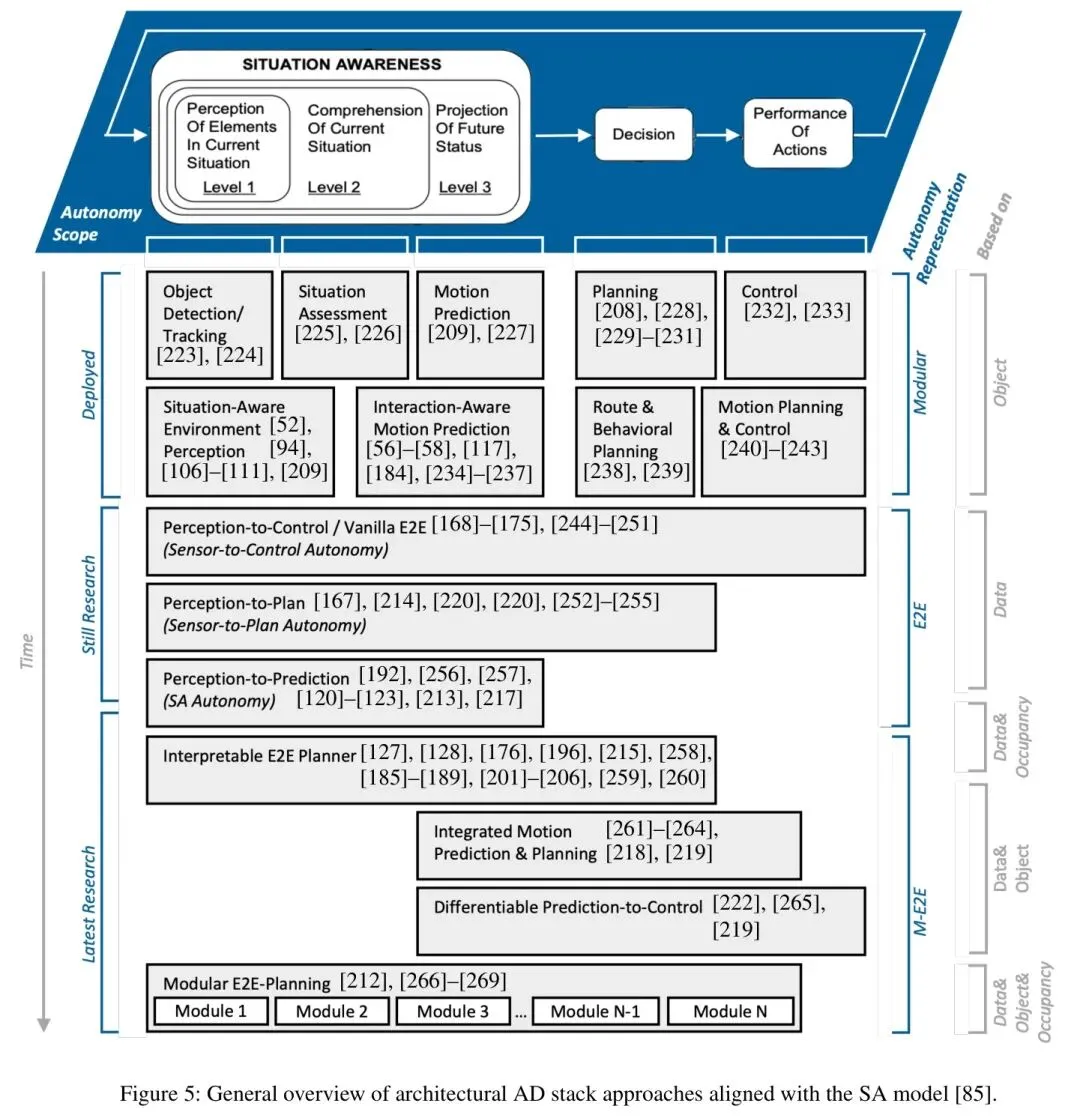

图5为我们清晰地勾勒了自动驾驶架构的演进全景。

可以看到,行业正从两个极端走向融合:

• 左端:模块化面向服务架构(Modular SOA)。优势:可解释、可调试、易于安全认证。劣势:信息损失、灵活性差、无法应对未知。 • 右端:纯端到端架构(Vanilla E2E)。优势:数据驱动、潜在性能上限高。劣势:黑箱、难调试、安全性存疑。

而中间的融合地带,才是未来的希望。论文将其最终形态定义为 面向服务的模块化端到端架构(Service-Oriented Modular End-to-End, SO-M-E2E)。

这个架构的核心思想是什么?用基于注意力机制的“软连接”,取代模块间的“硬编码”;用一个持续更新的“上下文层”,赋予系统“场景理解”的能力。

💡 核心机制一:注意力驱动的“软接口”

传统架构中,感知模块固定输出“目标列表”,预测模块固定接收这个列表。这是一种刚性耦合。

SO-M-E2E架构的突破在于,引入了 基于Query的注意力接口。

想象一下,规划模块不再被动接收感知模块的“推送”,而是可以主动向整个系统“提问”:

• “我前方50米,最可能影响我变道的物体是什么?” • “右侧盲区有没有突然出现的行人风险?” • “当前路况下,摄像头和激光雷达哪个信息更可靠?”

这些“问题”(Query)通过注意力机制,动态地从原始传感器数据、中间特征图、甚至历史信息中,“抽取”出最相关的信息。接口从“固定格式”变成了“按需定制”。

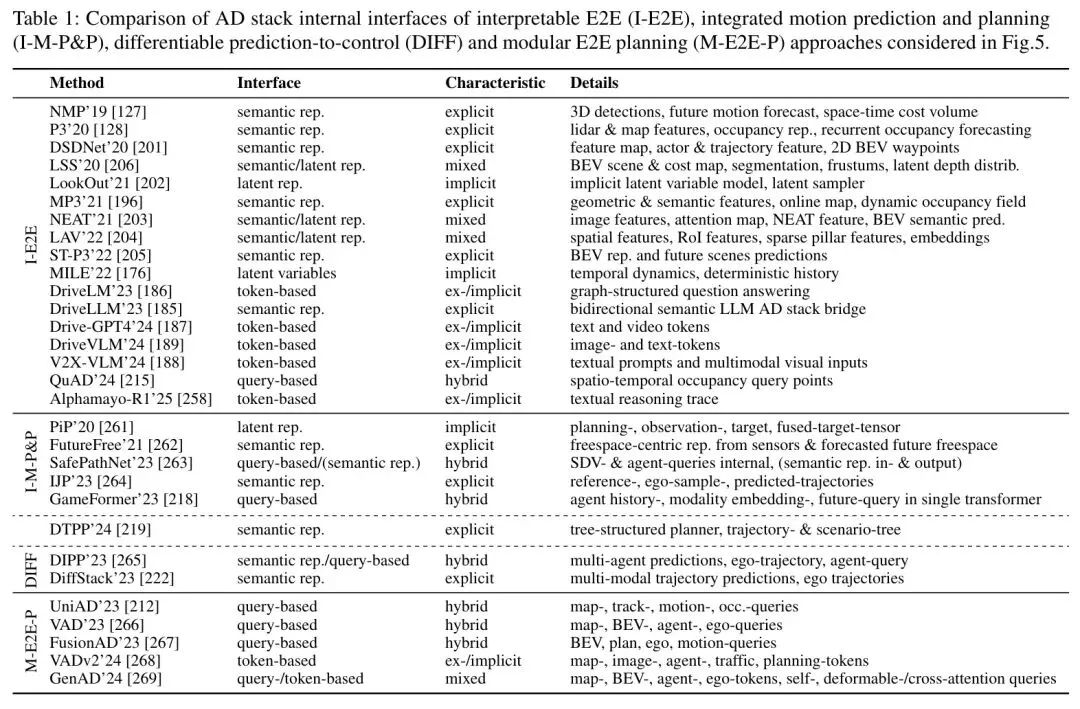

表1对比了不同架构的内部接口形式:

可以看到,基于Query的接口是混合式的,它使用显式的Query来提取隐式的、最相关的信息。这就像是一个认知协调器,在最高系统层面,根据上下文动态地决定信息如何流动、哪些信息更重要。

💡 核心机制二:持续演进的“上下文层”

仅有灵活的接口还不够。系统需要一种“记忆”和“理解”能力,这就是上下文层(Context Layer)。

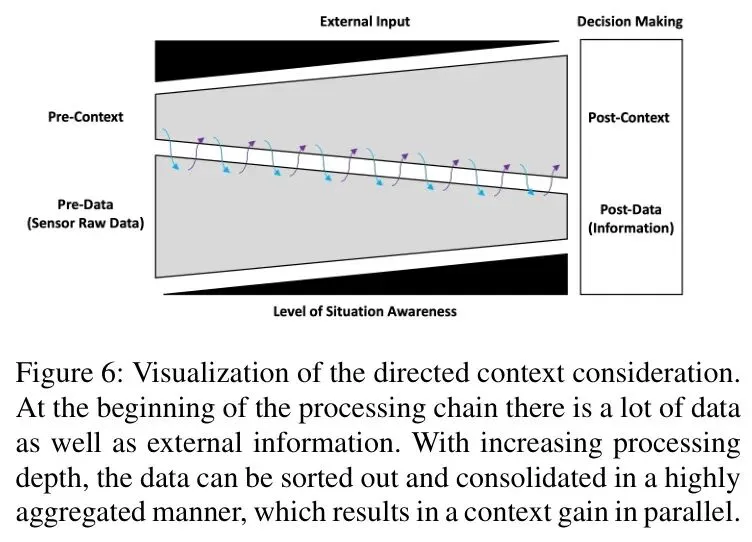

如图6所示,上下文层是一个贯穿整个信息处理链的“意识流”。

它如何工作?

1. 初始输入:接收高清地图、V2X车联网信息、天气数据等先验知识(标记为e1),编码成初始上下文状态c1。 2. 指导感知:基于c1(例如“前方是学校区域”),第一个注意力阶段可以聚焦于感知任务(如检测小目标、判断行人意图),并过滤掉无关数据。 3. 动态加权:第二个注意力阶段可以根据c1(例如“当前大雨”),动态调整摄像头、雷达、激光雷达等不同传感器的置信度权重。 4. 循环更新:处理过程中产生的新认知(如“检测到校车停下”),会实时反馈到上下文层,更新c1到c2,形成一个不断学习和演化的世界模型。

这个上下文层,本质上是在模拟人类驾驶员的经验库和瞬时判断。它让系统从“看到像素”进化到“理解场景”。

💡 核心机制三:内外融合的“超感知”

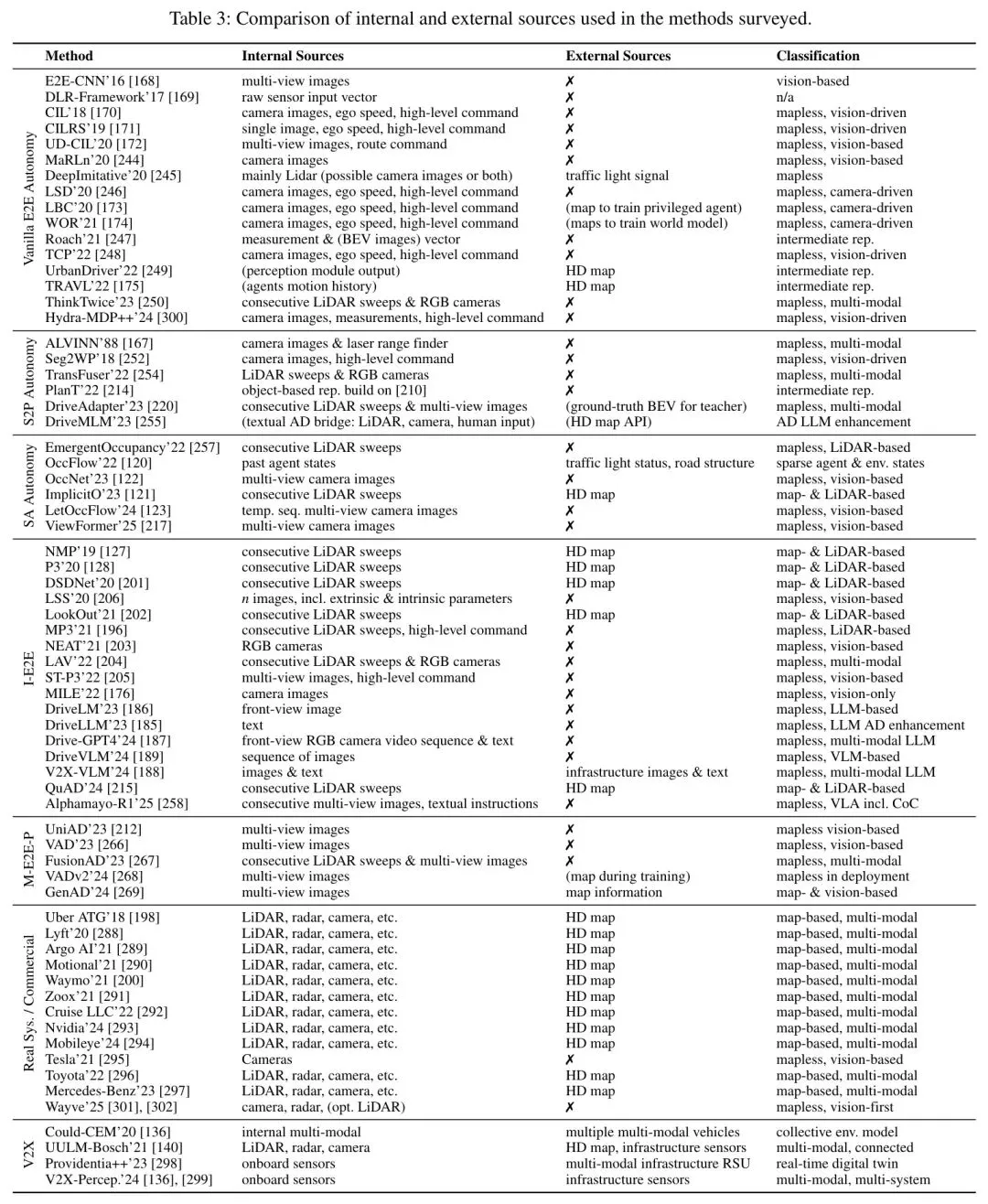

SO-M-E2E架构的第三个支柱,是对外部信息的深度利用,如表3所示。

目前,无论是特斯拉的纯视觉方案,还是Waymo的多传感器融合,都主要依赖车载传感器。这就像让人闭着一只眼睛、捂着一只耳朵开车。

未来的系统将深度融合:

• 车联网(V2X):获取其他车辆意图、路口信号灯相位、云端交通事件。 • 智能基础设施:路侧单元提供超视距、无遮挡的上帝视角。 • 高清语义地图:不仅提供几何信息,更提供“这里是什么地方”(学校、医院、商圈)的语义知识。

通过注意力机制,系统可以像人类一样,动态评估不同信息源的可信度和相关性,实现“1+1>2”的超感知能力。

💡 实战思考:这个架构听起来很美好,但它真的能解决开头提到的“未干混凝土”问题吗?关键在于上下文层能否从先验知识(如高清地图标注的“施工区”)或V2X信息中,触发对“非标准路面”的警惕,并指导感知模块进行更细致的材质或状态分析,而不是简单地分类为“可行驶道路”。

🚀 认知内核:三级态势感知的深度拆解

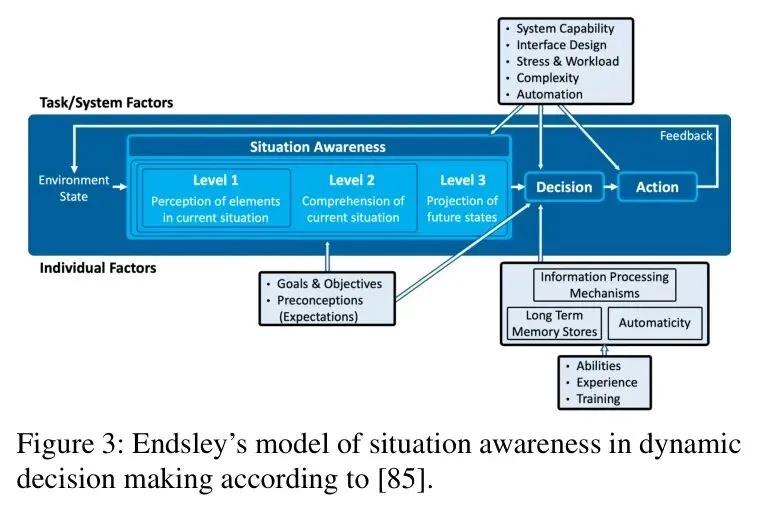

理解了架构,我们还需要深入其“认知内核”——态势感知(Situation Awareness, SA)。论文借鉴Endsley模型,将其分为三级,这恰恰是系统智能程度的标尺。

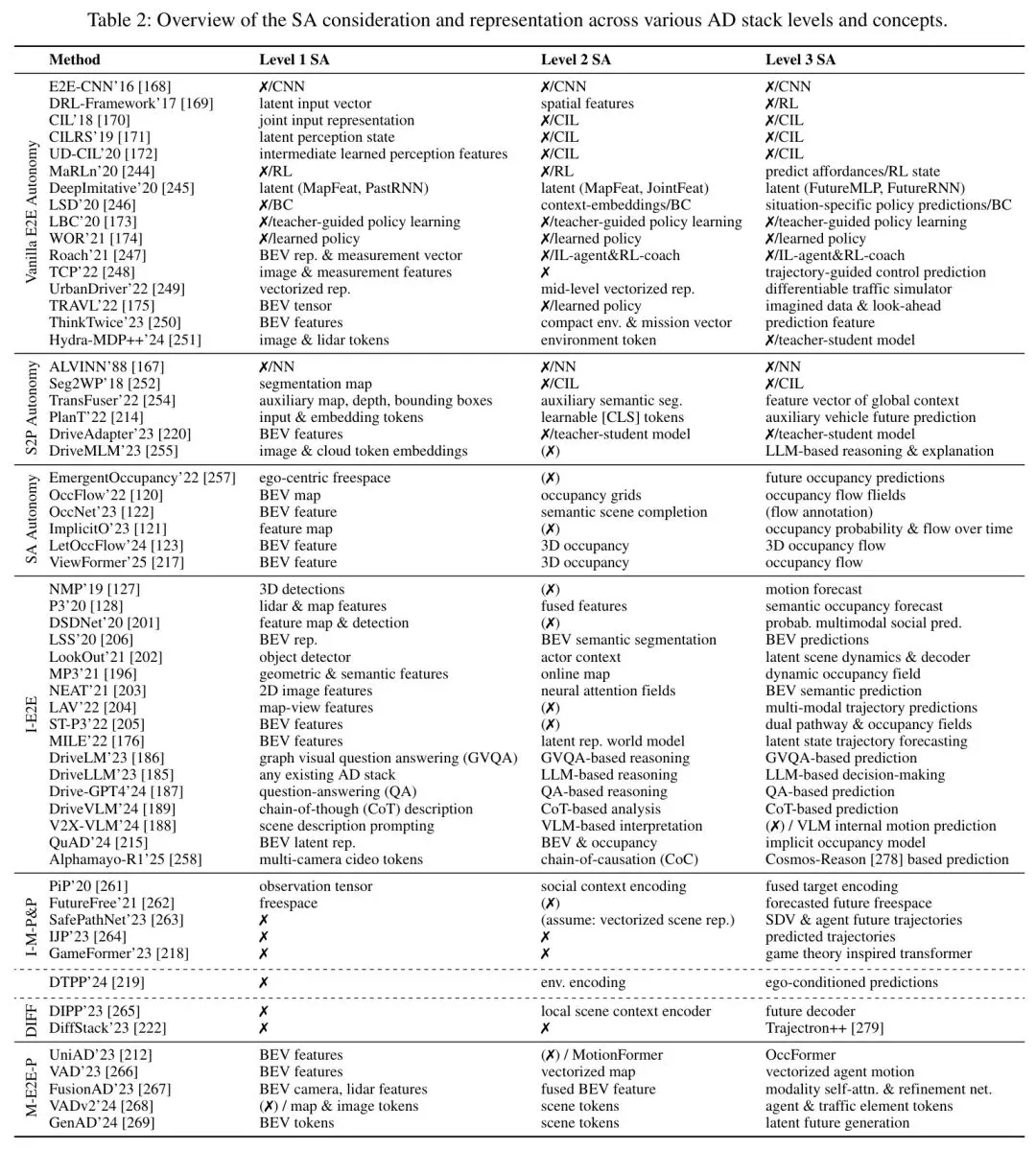

表2系统梳理了不同方法在这三级上的表现:

🔬 一级感知:从“识别框”到“理解场”

传统方法输出的是一个个离散的“目标检测框”。但世界是连续的。一个行人下一秒可能出现在框外的任何位置。

因此,先进的方法转向输出 “占据栅格(Occupancy Grid)”或“占据流(Occupancy Flow)”。这不是预测某个具体行人的轨迹,而是预测整个空间在未来每一刻被占据的概率。

这带来了根本性优势:

• 天然处理不确定性:无需对“目标是否成立”做二值判断。 • 更好的泛化性:对训练集中未出现过的物体类别(比如一只鸵鸟),也能给出“有物体占据”的概率。 • 符合物理直觉:规划模块直接基于物理空间的安全性进行决策,而不是基于抽象的目标ID。

从“目标驱动”转向“空间占据驱动”,是认知升级的第一步。

🔬 二级理解:填补“语义鸿沟”

二级感知的核心,是回答“这意味着什么?”

回到学校的例子。系统不仅要知道“那里有一群像素被分类为儿童”,更要能推理出:“儿童在放学时段出现在学校附近,其行为具有高随机性和低可预测性,属于高风险交通参与者。”

如何实现?这需要上下文层融合:

• 时空上下文:时间(工作日15:30)、地点(学校正门)。 • 社会常识:儿童的典型行为模式。 • 交通规则:学校区域减速、避让行人的要求。

在SO-M-E2E架构中,这种理解不是某个模块的孤立输出,而是贯穿整个信息处理链的共识。感知模块会因此更关注儿童的微动作;预测模块会生成更保守的多模态轨迹;规划模块会直接采用更低速、更宽安全边际的策略。

🔬 三级预测:从“线性外推”到“博弈推理”

三级感知是对未来的预测。传统顺序式“感知->预测->规划”流程存在致命缺陷:它假设其他交通参与者的行为与自车规划无关。

但实际上,驾驶是一场实时博弈。你的一个变道意图,会立刻影响旁车道司机的行为。

因此,前沿研究聚焦于 “预测与规划一体化” 的框架。如图3所示的动态系统态势感知理论模型,强调了个体与环境、决策与结果之间的循环影响。

在SO-M-E2E架构中,基于注意力的协调器可以动态协调预测与规划模块:

• 规划模块生成若干候选轨迹。 • 预测模块以这些候选轨迹为条件,预测其他交通参与者可能的反应。 • 协调器评估不同“自我-他人”交互组合的风险与收益,选择最优策略。

这实现了从“我预测你会怎样,然后我决定我该怎样”到“我考虑我怎样做时你会怎样反应,从而选择对我们都更好的方案”的质变。

🤔 深度互动:你认为,在“预测-规划”这场博弈中,自动驾驶应该表现得像一位“激进的老司机”,还是“保守的新手”?哪种策略在复杂中国路况下长期来看更安全?欢迎在评论区分享你的高见!

📊 实现路径:数据、训练与可迁移性的破局点

再完美的架构,也需要可行的落地路径。论文指出的核心在于:将“感知-轨迹”作为可迁移的认知核心,并通过数据引擎和联邦学习实现规模化。

🏆 核心模型:可迁移的“感知-轨迹”世界模型

论文提出了一个极具洞察力的设想:训练一个 Baseline 感知到轨迹模型(Perception-to-Trajectory, P2T)。

这个模型类似于语言领域的“基础大模型”(Foundation Model):

1. 通用预训练:在海量、多样化的全球驾驶数据上,学习通用的驾驶常识、物理规律和社会行为规范。这构成了模型的“认知基座”。 2. 领域微调:针对特定国家、地区(ODD,运行设计域),用本地数据微调。就像人类到了新地方要学习当地交规和驾驶习惯。研究表明,针对性的微调远胜于笼统的多任务学习。 3. 系统适配:针对不同车型、传感器配置,进行最后的适配优化,确保模型能与具体的硬件系统协同工作。

这个P2T模型,就是SO-M-E2E架构的“大脑”。它集成了驾驶所需的认知能力,并且像人类驾照一样,具备“考取”不同国家“驾照”(微调)的潜力。

🔬 关键燃料:自动化场景生成与数据引擎

但是,哪里来那么多覆盖“长尾边缘案例”的数据?尤其是致命但罕见的事故场景。

论文的答案是:自动化场景生成器 + 联邦学习。

1. 迁移关键案例:假设特斯拉在美国记录了一个“撞入施工区”的关键场景,但数据只有摄像头视频。生成器可以自动地: • 将场景背景迁移到德国街道。 • 根据德国路标规范,合成对应的交通标志。 • 为激光雷达、雷达等模态,生成物理一致的合成点云和射频信号。 2. 创造极端测试:利用“想象力”,生成无数人类都难以想象的极端测试用例,用于锤炼模型的鲁棒性。 3. 联邦学习保障隐私:各车企在本地用自己的数据微调中央P2T模型,只上传模型参数更新,而不共享原始数据,解决数据隐私和商业机密问题。

这套数据引擎,是实现持续迭代和安全进化的核心。它与特斯拉的“数据引擎”概念和Waymo的“安全判定生命周期”不谋而合,但上升到了跨企业、跨地域协作的层面。

⚖️ 终极考验:安全认证与法规适配

最后,也是最难的一关:如何让这样一个复杂、动态、数据驱动的AI系统,通过严苛的汽车安全标准(如ISO 26262, ISO 21448)和新兴的AI法规(如欧盟AI法案)?

论文指出了范式转变的必要性:从“基于规则的确定性认证”转向“基于数据的概率性论证”。

• 传统方法:证明代码的每一行都符合规范,逻辑链清晰可追溯。 • AI系统方法:需要证明,在海量的、代表性的测试场景下,系统的失效概率低于某个可接受的极低阈值(如10^-9每小时)。这需要: • 可解释的决策过程:SO-M-E2E架构保留的语义接口和上下文层,为“为什么这样决策”提供了追溯线索。 • 持续监控与学习:像飞机黑匣子一样,记录行驶数据,用于事后分析和模型迭代。 • 安全护栏:即便认知核心出错,底层仍要有基于规则的、经过传统认证的“最小风险策略”作为最后兜底。

这不仅是技术挑战,更是工程流程、监管框架和社会信任的系统性重建。

🌟 价值升华:这不是技术迭代,而是出行范式革命

总结来看,这篇论文描绘的不仅是一个技术架构,更是一条通往全自动驾驶的认知革命之路。

给研究者的启示:

1. 放弃“模块化即安全”的幻想:真正的安全来自于系统应对未知的“韧性”,而非模块的“孤立正确”。 2. 拥抱“注意力即协调”的范式:基于Query的注意力机制,是构建柔性、自适应信息处理链的关键。 3. 聚焦“可迁移的认知核心”:未来的竞争,在于谁能训练出更通用、更可微调的驾驶“世界模型”。

给行业从业者的价值:

1. 看清融合趋势:纯模块化或纯端到端的路线都已接近瓶颈。SO-M-E2E是必然的融合方向。 2. 重估数据战略:高质量、多样化的数据,以及自动化生成极端场景的能力,将成为比算法模型更核心的资产。 3. 提前布局认证:与认证机构、法规制定者共同探索适用于AI驱动系统的安全论证方法,将构成未来的准入壁垒。

从更宏大的视角看,我们正在从“自动化驾驶”(Automated Driving)走向“自主驾驶”(Autonomous Driving)。前者是机器的延伸,执行预设指令;后者是具身的智能,拥有理解和适应世界的能力。

当车辆真正拥有“认知”,它不再只是交通工具,而是移动的智能空间、协作的社会节点、持续进化的数字生命体。这场革命,将重新定义我们与空间、时间以及彼此之间的关系。

🤔 终极思考:如果未来的汽车真的拥有接近人类的场景理解与博弈决策能力,你认为最颠覆性的应用场景会是什么?是彻底重塑城市交通流,催生全新的车内娱乐与办公生态,还是成为家庭与社会的“第三空间”?

💝 支持原创:如果这篇近6000字的深度解读帮你拨开了自动驾驶的重重迷雾,点赞+在看就是最好的支持!分享给你身边对AI和出行未来感兴趣的朋友!

🔔 关注提醒:设为星标,第一时间获取更多硬核技术解读与前沿趋势分析!

#AI技术 #自动驾驶 #人工智能 #技术干货 #论文解读 #认知革命 #出行未来

参考

Toward Fully Autonomous Driving: AI, Challenges, Opportunities, and Needs