大家好,我.是.速哥。今天咱们聊一个有.点烧脑.但也特别有意思.的东西——自动驾.驶的“眼睛”,也就是它怎么看懂点云信息的。最.近不少粉丝私.信问我,说速哥.你不是爱.研究各种车嘛,那自动驾驶这种Lidar采上来的点云,它怎么看路、怎么看人?这事.我.还.真研究了几天,越看越.上头。

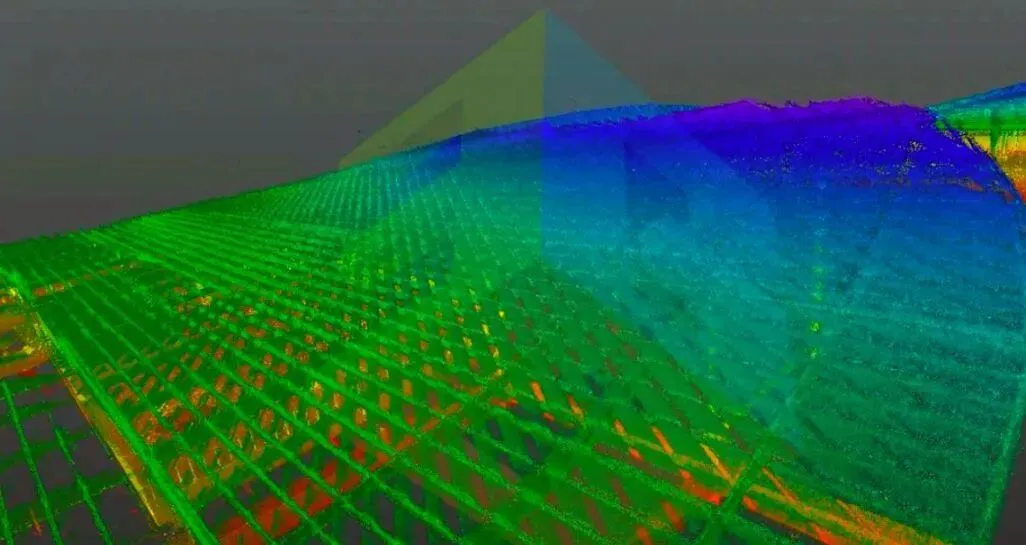

先说个直白.的,点云其.实就.是无数个“小点点”,每个点都有X、Y、Z三维坐标,有.的还带反射强度这种附加信息。自动驾驶的车.靠激光雷达打出去的.光,反射回来再组合成三.维图,就像是画素版的世界。别看这些.点单独看没啥意义,但机器通过算法能从中抽出语义信息,比如“这团点可能是.个.行.人”,“这条线是路沿”之类的。

现在主流的模型一般有两条.技术路线,一个是基于投影的,比如把点云投影到二维平面上,方便卷积神经网.络(CNN)去提.特征;另一个是基于体素(Voxel)的,这就更.接近人类理解空间的方式,把三维世界分成一个个小格子,然后模型像扫描一样去判断每个体素里有什么。这个思路目前很多.厂都在用,比如特斯拉、百度Apollo、小鹏这些,尤其是.配合BEV(Bird’s Eye View)视角后,识别精度提升特别明.显。

我之前试过一台装有128线激.光雷达的测试车,在西.安绕城高速那一段,大家都知道.那边有好几个上坡拐弯。你能明显感受到点云的数.据密度变化特别剧.烈,车的算法就要实时“补洞”一样去理解这个.世界。模.型.如果处.理.不好,就可能漏识别或者出现飘车的情况。所以后来很.多团.队在研究“稀疏.点云优化”,像使用Transformer结构的,那精度和鲁.棒性肉眼可见地上去了。

然后我们得聊聊这.个.所谓“看懂”里的关键:特.征提取和语义理解。这.个过程.挺像.我们肉眼看东西——先抓轮.廓,再猜类别。模型一开始会通过神经网络提取空间关系,比如哪些点聚在一起,角度什么.样,再往上叠一层.层网络,逐渐从“这些点长得像个立方体”升华到“这.是辆车”这种认知。有意思的是,现在很多AI模型还能自动学习时间维度的信息,也就是说它不只是看这一帧,而是结合前后的帧.一起去推断静态和动态的物体,这点真是越来越像人脑的.判.断方.式了。

说个我个人挺喜欢的小细节,现在很多算.法都.加入了多模态融合,也.就是把点.云和摄像头、毫米波雷达的数据结合在一起。这个组合最妙的地方.是.互.补性。比如光.照差.的时候雷达更稳定,视觉.模糊.时点云来帮忙。就像.我平时试车,有时候眼睛看不清,但屁.股那一阵推背感骗不.了你,一个.道理。

当然话.说回来,自动驾驶离完.全“懂这.个世界”还差得.远。我上次看.了一篇2024清华那.边.的论.文,他们提到动态场景下行人预测的误差率依旧在5%左右。听起.来不多,但这在行车中已经是致.命差距.了。所以现在业内都在朝.着自监督.学习方向走,就是让模型自己去“看懂”点云,而不是全靠人.工标注。

总的来说,点云其实是自动驾驶的“世.界底图”,模型就是要.学会怎么把这些离散的点,拼成一.个能理解、能预测的连续空间。听起来有点.抽象哈,但换成车上的表现就是.更稳、更准、更.像.人。要是以后能.做到一边跑一边学、学完.还能自己优化决策,那.就.真是AI司机了。

好.了,这次就.聊到.这。我知道有朋友想让我讲讲.特斯拉的视觉方.案和华为的融合算法,那个我改天单独开一.篇说。文章写作不易,还望.大.家多多支持,点赞.评论收藏一下,感谢大家。