自动驾驶视觉 ≠ 人类视觉!详解FSD Vision Only方案

- 2026-02-04 18:40:53

「FSD Vision Only视觉方案详解」

FSD 的纯视觉方案以 “原始光子数据驱动 + 神经网络自主感知” 为核心,通过传感器硬件优化、跳过 ISP 处理、LiDAR 辅助训练三大关键设计,实现无需量产 LiDAR 的 3D 环境理解与安全驾驶,核心是让 AI 而非硬件定义感知逻辑。本文直接参考《Phil Beisel’s articles on FSD and AI》系列文章。

Phil Beisel是聚焦特斯拉 FSD(完全自动驾驶)与 AI 技术的资深科技分析师、行业观察者,同时具备深厚的工程背景,其研究与分享长期围绕特斯拉自动驾驶技术迭代、Optimus 机器人研发及 “物理 AI” 领域的创新展开,是解读特斯拉前沿技术逻辑的关键人物之一。

FSD 纯视觉方案的核心逻辑是 “复刻人类视觉驾驶逻辑,但是只复刻逻辑,不复制人眼机制”:人类仅通过眼睛(视觉)即可安全驾驶,FSD 通过优化摄像头硬件、保留原始数据、让神经网络自主学习场景特征,替代 LiDAR 的深度感知功能,同时降低硬件复杂度与成本。

其核心目标是“结果导向的感知”—— 不追求生成人类可见的图像,而是让 AI 直接从传感器原始数据中提取驾驶所需的关键信息(如物体距离、路况、交通信号)。

激光雷达(Light Detection and Ranging),通过发射激光脉冲测量物体距离、生成 3D 点云的传感器,传统自动驾驶常用,具备精准深度感知能力,但成本高、硬件集成复杂。

深度感知是对场景中物体的距离、尺寸、空间位置等 3D 信息的识别能力,是自动驾驶安全行驶的核心基础。

结果导向的感知是指,感知过程不以生成人类可理解的图像为目标,而是直接提取驾驶决策所需的关键数据(如“前方 50 米有行人”“左侧车道有车辆逼近”),服务于最终驾驶行为。

1. 摄像头配置

量产车搭载 8 颗摄像头,实现 360° 无死角覆盖,捕捉车辆周围全场景数据,为神经网络提供完整的环境输入。

摄像头核心作用:采集原始光信号(光子photon数据),而非生成人类可观看的图像,数据直接用于模型训练与实时推理。

8 颗摄像头分别部署在车辆前视、后视、侧视等关键位置,组合后可覆盖车辆周围所有方向,消除视野盲区,确保无环境信息遗漏。

光子数据是光线的基本粒子信号,摄像头传感器将光子转化为电信号,是最原始、未经过任何加工的图像数据来源,包含最完整的环境细节。

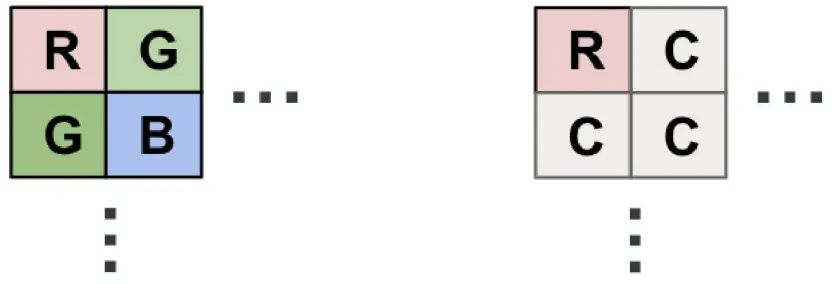

2. 滤镜方案革新:RCCC 替代传统 RGGB

传统相机滤镜(RGGB):采用 “红 - 绿 - 绿 - 蓝” 配置,因人类眼睛对绿色更敏感,双绿色通道用于提升图像锐度和亮度细节,但会丢弃驾驶相关的关键光谱信息。

FSD 的 RCCC 滤镜:采用 “红 - 透明(clear) - 透明 - 透明” 配置,针对性优化驾驶场景:

图| RCCC与RGGB对比©【深蓝AI】编译

红色通道:专门捕捉道路关键信号(如刹车灯、停车标志、交通信号灯),强化驾驶相关特征识别;

透明通道:无颜色过滤,记录全可见光谱的原始光子计数,最大化光信号灵敏度,保留更多环境细节(如路面阴影、微弱光线条件下的物体轮廓)。

滤镜:摄像头传感器表面的彩色滤光片阵列,用于分离不同波长的光线(红、绿、蓝等),让传感器捕捉色彩信息,不同配置适配不同使用场景。

RGGB 滤镜:传统相机常用的滤光片配置,“红 - 绿 - 绿 - 蓝” 排列,因人类视觉对绿色敏感度最高,双绿色通道可提升图像亮度和锐度,但对驾驶关键的红色信号无针对性优化。

RCCC 滤镜:FSD 专属滤光片配置,“红 - 透明 - 透明 - 透明” 排列,红色通道聚焦驾驶关键信号,透明通道无过滤,最大化接收全光谱光子。

光谱信息:不同颜色的光线对应不同波长,驾驶场景中红色(刹车灯、停车标志)、黄色(转向灯、警示灯)是核心信号,光谱信息的完整保留直接影响信号识别准确率。

光信号灵敏度:传感器捕捉微弱光线的能力,透明通道无滤光阻碍,能接收更多光子,提升夜间、雨天等弱光环境下的数据采集效果。

RGGB 中“G(绿色)写两次”,核心原因是人类视觉对绿色光最敏感,双绿色通道能提升图像的亮度细节与锐度,适配人类观看需求——这是传统相机滤镜设计的核心逻辑,也是 RGGB 成为行业主流配置的关键。

人眼视网膜上的视锥细胞(负责彩色视觉)中,感知绿色的视锥细胞数量最多(约占60%),远多于感知红色(30%)和蓝色(10%)的细胞。

这意味着人类对绿色光的亮度变化、细节差异最敏感,绿色通道的信息质量直接决定了图像在人眼看来的“清晰程度”和“舒适感”。

RGGB 双 G 通道的具体作用如下:

提升亮度与锐度:绿色光的波长(约550nm)处于可见光光谱的中心,能更好地反映场景的亮度分布。双 G 通道相当于“加倍采集”亮度相关信息,让图像的明暗过渡更细腻、边缘轮廓更清晰,避免出现模糊感。

平衡色彩与数据量:如果仅用单 G 通道,会导致亮度细节不足;若增加 R 或 B 通道数量,又会因人类对其敏感度低而“浪费数据”(还会增加后续处理压力)。RGGB(1R+2G+1B)的比例,是在“色彩还原”与“亮度细节”之间的最优平衡——既保证了彩色图像的真实性,又最大化利用了人眼的感知特性。

3. 适配后续图像处理:

传统相机的 ISP(图像信号处理器)在“去马赛克”(还原彩色图像)时,双 G 通道能提供更丰富的插值参考,减少色彩失真和噪点,让最终生成的 JPEG 图像更符合人类视觉审美。

那么对比 FSD 的 RCCC,为何不需要双 G?

RGGB 的双 G 是为“人类观看”优化的,但 FSD 的 RCCC 滤镜核心目标是“AI 驾驶决策”——AI 不需要符合人类审美的图像,只需要精准捕捉驾驶关键信息(如红色刹车灯、道路阴影、物体轮廓)。

透明通道是 FSD 的 RCCC 滤镜中 “无颜色过滤的通道”,核心作用是不筛选任何波长的可见光,完整记录场景的原始光子数据,为神经网络提取驾驶关键信息(如物体轮廓、路面阴影、弱光信号)提供最全面的原始输入。透明通道无滤光、全光谱接收,没有红色、绿色、蓝色等彩色滤镜,能接收可见光范围内所有波长的光子(从红光到蓝光),不像传统 RGGB 滤镜的绿色通道只针对性捕捉绿色光。

因此 RCCC 用“1个红色通道(强化交通信号)+3个透明通道(保留全光谱光子数据)”替代双 G,放弃了人类视觉优化,转而让神经网络自主提取驾驶所需的亮度、距离等特征。

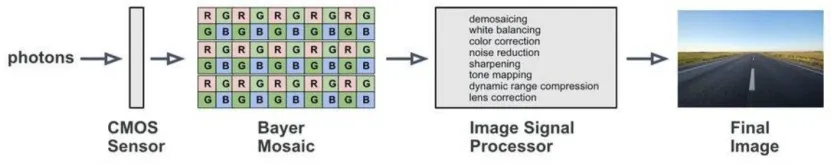

1. 传统相机数据处理流程(被 FSD 舍弃)

传统数字相机的处理链路:CMOS 传感器采集原始数据 → 图像信号处理器(ISP)执行一系列处理(去马赛克、白平衡、色彩校正、降噪、动态范围压缩)→ 生成 JPEG 等人类可观看的图像。

图| 典型的图像处理pipeline©【深蓝AI】编译

该流程的问题:丢弃大量原始光子数据,压缩动态范围,且优化方向是“符合人类视觉审美”,而非 “适配驾驶决策”。

其中的关键概念如下:

CMOS 传感器:互补金属氧化物半导体传感器,相机的核心感光部件,负责将光子(光信号)转化为电信号(数字数据),是图像数据的源头。

ISP(Image Signal Processor):图像信号处理器,专门处理传感器采集的原始数据,通过一系列算法优化图像质量,使其符合人类观看习惯的硬件模块。

去马赛克(Demosaicing):将传感器捕捉的单像素颜色数据(如 RGGB 阵列中每个像素仅记录一种颜色),通过插值算法还原为完整彩色图像的过程。

白平衡:调整图像颜色,抵消不同光源(如阳光、灯光、阴天)导致的色偏,让白色物体在图像中呈现真实白色的处理步骤。

色彩校正:修正图像的色彩还原度,使其更接近人眼所见的真实色彩,提升视觉舒适度的处理步骤。

降噪:过滤图像中的电子噪声(如弱光下的颗粒感),让图像更清晰,但可能会模糊部分细节的处理步骤。

动态范围压缩:缩小图像中亮部与暗部的亮度差异,避免亮部过曝(细节丢失)、暗部过暗(无法分辨),符合人类视觉对亮度感知范围的处理步骤。

JPEG:常见的图像压缩格式,通过丢弃部分原始数据减小文件大小,适合人类观看和传输,但会损失 AI 训练所需的细节信息。

动态范围:图像中最亮部分与最暗部分的亮度比值,动态范围越高,能呈现的明暗细节越丰富。

2. FSD 的极简数据处理流程

核心操作:完全跳过 ISP 处理,将 CMOS 传感器采集的 12 位原始 Bayer 马赛克数据(RCCC 格式)直接输入 FSD 的训练与推理系统。

这样一来保留原始光子级数据保真度,不丢失动态范围和细节(如强光下的阴影区域、弱光下的交通信号);

二来让神经网络成为“自主过滤器”。AI 根据驾驶结果(如是否安全避障、是否识别信号)自主判断数据中哪些信息重要,而非依赖 ISP 的人类导向处理逻辑。

其中关键概念解释如下:

12 位原始数据:传感器每个像素的电信号用 12 位二进制数表示,可呈现 4096(2¹²)个亮度等级,比常见的 8 位数据(256 个等级)保留更多亮度细节,能精准捕捉明暗差异。

Bayer 马赛克数据:传感器上滤镜阵列(如 RGGB、RCCC)采集的原始数据格式,每个像素仅记录一种颜色或全光谱信息,未经过去马赛克、色彩校正等任何处理,是最原始的图像数据形态。

数据保真度:原始数据未被修改、压缩或丢弃,完整保留了场景的原始信息,为 AI 模型提供最真实、最全面的输入,确保学习到的规律准确可靠。

自主过滤器:神经网络不依赖预设的图像处理规则,而是通过驾驶结果的反馈(如“识别到停车标志后停车则安全”),自主学习哪些数据特征(如特定波长的红色信号)对驾驶决策重要,动态调整感知重点。

Bayer 指拜耳滤镜阵列(Bayer Filter Array),是数字相机传感器上的彩色滤光片排列方式,也是 FSD 原始图像数据的核心格式基础 —— 不管是传统 RGGB 还是 FSD 革新的 RCCC 滤镜,本质都是基于 Bayer 阵列的变体设计。

Bayer 是一种将红(R)、绿(G)、蓝(B)或其他颜色滤光片,按固定规律覆盖在 CMOS 传感器像素上的阵列结构。其核心作用是让传感器的每个像素只捕捉一种颜色的光信号,再通过后续处理(如去马赛克)还原出完整彩色图像,是数字相机获取彩色数据的行业标准方案。关键细节

由柯达公司的工程师 Bryce Bayer 于 1976 年发明,因此以他的名字命名,至今仍是消费级相机、手机摄像头的主流滤镜排列方式。

经典排列规律(RGGB)是传统 Bayer 阵列的核心比例是「1 红 + 2 绿 + 1 蓝」,即每个 2×2 的像素块中包含 1 个 R 像素、2 个 G 像素、1 个 B 像素,重复排列覆盖整个传感器。前面有图已经表示了。

1. LiDAR仅用于研发阶段的 “地面真值标注”

FSD 量产车无 LiDAR,但在研发与训练阶段,LiDAR 作为 “3D 深度参考工具”,帮助神经网络学习从 2D 图像中推断 3D 信息:

LiDAR 用于生成高密度点云数据,提供场景中所有物体的精确 3D 结构(如物体距离、尺寸、空间位置),作为 “地面真值”。

然后将 LiDAR 的 3D 数据与摄像头采集的 2D 图像序列配对,让神经网络学习 “2D 像素变化与 3D 空间的对应关系”—— 例如通过分析连续帧中物体的像素移动(运动视差),结合 LiDAR 标注的真实距离,学会自主估算物体距离和尺寸。

里面的关键概念如下:

地面真值(Ground Truth):在 AI 训练中,用于衡量模型输出准确性的真实数据,ground是基准的意思,不是路面地面(如 LiDAR 测量的精确距离、人类标注的物体类别),是模型参数调整的核心依据。

点云数据:LiDAR 发射的激光脉冲反射后形成的大量三维坐标点集合,每个点包含距离、空间位置等信息,可精准还原场景的 3D 结构,是深度信息的 “黄金标准”。

2D 图像序列:摄像头连续拍摄的多张 2D 静态图像(如每秒 30 帧),记录场景随时间的动态变化,包含物体的运动轨迹、位置偏移等信息。

运动视差:当观察者(车辆)移动时,近处物体在图像中的位置变化速度比远处物体更快,通过这种差异可反向推断物体的距离远近,是人类和 AI 从 2D 图像中感知 3D 空间的关键原理。

2. 神经网络的 3D 感知能力培养

核心方法是通过“多帧图像序列分析 + 运动视差推理”,从 2D 数据中提取 3D 信息。

比如,当车辆接近一组不同距离的箱子时,神经网络通过分析连续帧中箱子的像素大小变化、位置偏移,结合车辆自身运动数据(IMU/GPS),推断箱子的实际距离和尺寸;若摄像头估算的距离(如 19-21 米)与 LiDAR 的精确值(如 20.05 米)存在偏差,训练过程会调整模型参数,最小化误差。

训练完成后,神经网络仅通过摄像头输入,即可准确估算物体的 3D 位置、距离和运动状态,实现与 LiDAR 相当的环境感知能力。

里面涉及的关键概念注释如下:

IMU(Inertial Measurement Unit):惯性测量单元,用于测量车辆的加速度、角速度、姿态(俯仰、横滚、偏航)等运动数据,辅助推断车辆与周围物体的相对运动关系。

GPS:全球定位系统,通过卫星信号获取车辆的地理位置、行驶速度、航向等信息,为 3D 环境感知提供空间参考框架。

模型参数调整:通过反向传播算法,根据模型预测值(如摄像头估算的物体距离)与地面真值(如 LiDAR 测量的精确距离)的误差,调整神经网络的权重和偏置,逐步提升模型的 3D 感知准确性。

3D 环境理解:AI 对周围环境的三维空间认知能力,包括物体的距离、尺寸、空间位置、运动方向和速度等关键信息,是自动驾驶车辆规划行驶路径、规避障碍物的核心基础。

有些概念很常见,本文为了完整性还是列出来了。

数据保真度高,跳过 ISP 避免数据丢失,原始光子数据让 AI 捕捉更多驾驶关键细节;

场景适配性强,RCCC 滤镜针对性优化驾驶场景,红色通道强化交通信号识别,透明通道提升弱光 / 复杂光线适应性;

成本与复杂度低,无需量产 LiDAR,仅通过摄像头 + AI 实现 3D 感知,降低车辆硬件成本,且便于大规模部署(所有特斯拉车型均可适配);

AI 能自主进化,感知逻辑由神经网络通过数据学习生成(always retraining),而非硬编码,能持续通过新数据优化(如识别罕见的停车标志变体)。

硬编码是指程序员手动编写的固定逻辑指令(如“若检测到红色圆形图案且直径大于 50 像素,则判定为停车标志”),仅能应对预设场景,无法适应未提前编程的复杂情况。

AI 自主进化是指模型无需人工修改代码,通过持续吸收新采集的驾驶数据(如罕见场景、新交通标志)进行再训练,不断优化感知精度和场景适配能力,实现自我迭代升级。

纯视觉方案仅依赖摄像头硬件,无需额外加装 LiDAR 等昂贵传感器,可快速适配所有特斯拉量产车型,加速自动驾驶技术的普及。

商务推广/稿件投递请添加:xinran199706(备注商务合作)

· 计划周期:深蓝学院将以3个月为一个周期,建立工程师&学术研究者的「同好社群」

· 覆盖方向:自动驾驶、具身智能(人形、四足、轮式、机械臂)、视觉、无人机、大模型、医学人工智能……16个热门领域

扫码添加阿蓝

选择想要加入的交流群即可

(按照提交顺序邀请,请尽早选择)

👇