风靡各大车企的自动驾驶VLA大模型,为何华为没有选择?

- 2026-02-02 10:31:39

作者 | 刘延@知乎

链接 | https://www.zhihu.com/people/liu-yan-14-92

编辑 | 自动驾驶之心

本文只做学术分享,如有侵权,联系删文

>>自动驾驶前沿信息获取→自动驾驶之心知识星球

VLA不是唯一解,只是未来路线中的一种。

关于华为对VLA路线的看法,我的解释基本对应的上。

VLA的优点在于,在架构中增加了大模型,具备一定现实理解能力,是当下端到端技术探索的新路线

关于VLA,得先从原理说起。

VLA是把摄像头、激光雷达、毫米波雷达,甚至车外麦克风等信息和自车信息持续输入,问一个大模型如何开车。

如果你截一张行车记录仪的图,问DeepSeek应该如何开车,并让它只输出怎么开车,恭喜你,你获得了VLA的雏形。

有了这个雏形,再去做工程上的优化,终归是会大力出奇迹的。

端到端模式,依然存在数据的边际效应递减问题,以及Corner Case覆盖不够的问题。

当然,端到端模型最大的问题不是这些,而是模型的AI只知道相关性,而非因果性。此外,还有个灾难性遗忘的问题。

相较于目前的端到端,VLA架构中增加了LLM——也就是大模型,因此具备了对于现实世界更好的理解能力。

虽然大模型是否具备真正的理解能力还有争议,但相较于上面的端到端仅有相关性没有因果性的理解,大模型起码知道,红灯应该停。

大模型,特别是中小参数模型性能的飞速增长,意味着在VLA中的这个“L”的能力,也可以飞速增长。

但VLA的缺点在于,对于硬件的要求,模型能力的上限,都受到了约束。

以理想为例,VLA大体可以看做四步:

1)识别图像; 2)把图像信息和自车信息输入大模型(也就是Prefill) 3)大模型输出驾驶建议(也就是Decode) 4)将输出建议画成自车轨迹+环境,提供真正的驾驶建议。

所有内容,先变成语言对环境的描述,然后输入到一个(尺寸不算大)的大模型中,让这个大模型判断怎么开车,然后画出来行车轨迹。

为了泛化,多了一道转化,也会导致信息量的损失。

当然,对算力、内存带宽的需求也极大增长。

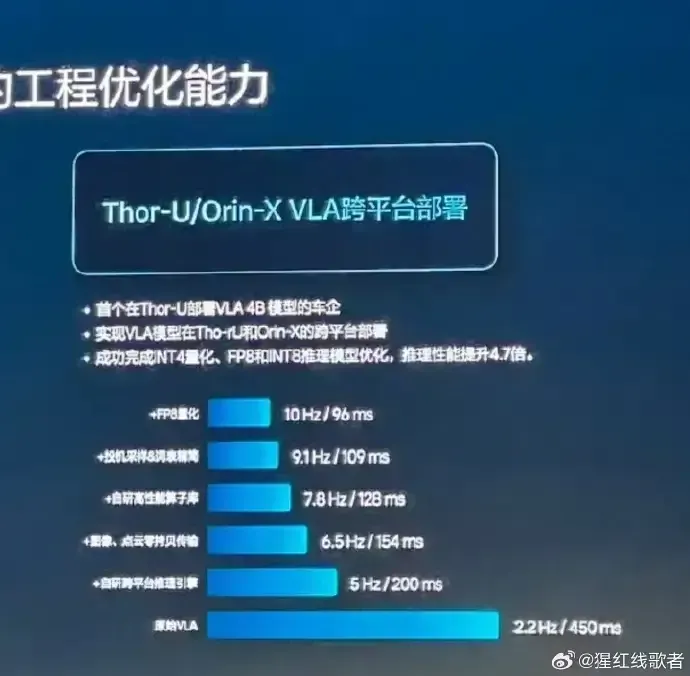

为了降低延迟,理想和小鹏都做了巨量的工程上的优化,

智驾的前沿模型还有世界模型和视频生成模型

——这不是我说的,这是王兴兴说的。

毕竟本来VLA也是之前具身智能领域拿过来的。

世界模型是直接通过环境信息,生成虚拟世界中对于未来的预测。

相较于VLA,世界模型少了两个步骤,即

2)把图像信息和自车信息输入大模型(也就是Prefill)3)大模型输出驾驶建议(也就是Decode)

这样,理论上不仅具备对世界环境的理解能力,也可以实现更低的延迟。

华为ADS 4.0的车端世界行为模型大体是这个意思。

大体如此吧。